[{"content":"开始一个新的项目 初始化 1 git init 添加remote 1 git remote origin add \u0026lt;url\u0026gt; 添加文件 1 git add 提交 1 git commit -m \u0026#34;注释\u0026#34; 同步 远端拉取 1 git push -u origin \u0026lt;branchname\u0026gt; 远端推送 1 git pull origin \u0026lt;branchname\u0026gt; 查看日志和状态 日志 1 git log --oneline 状态 1 git status 删除文件 彻底删除 1 2 git rm filename git rm -r filedir 从git删除而不物理删除 1 2 git rm --cached fielname git rm --cached -r filedir 执行了git add,尚未commit 1 git restore --staged fielname 恢复文件 1 2 3 - 执行了git rm 未commit git reset head git restore \u0026lt;file|dir\u0026gt; 分支 查看分支 1 git branch 后面没有接任何参数,它仅会输出当前在这个项目中有哪些分支。git默认会设置一个名为master的分支,前面的星号(*)表示现在正在这个分支上。\n新增分支 1 git branch \u0026lt;分支名\u0026gt; 改分支名 1 git branch -m 老分支名 新分支名 删除分支 1 git branch -d 要删除的分支名 若被删除的分支还有未被合并的内容,会有提示,无法删除,此时需要使用-d强行删除\n1 git branch -d 要删除的分支名 切换分支 | 切换分支之前,首先得查看当前分支状态,看看有无未更改的提交,若不想提交,则需贮藏修改\n已存在分支切换 1 git checkout 分支名 不存在分支,创建并切换 1 git checkout -b 分支名 恢复已被删除的分支 已合并的分支随意删除\n未合并的分支若被删除\n使用 git reflog 删前的版本号,reflog 保留30天记录 使用 git branch branchname version 老创建新的分支恢复 合并 概念 在a上合并b, a为当前分支,b为被合并分支\nmerge 合并 git merge b master 主分支其余分支,使用快转模式直接合并 子分支合并子分支,会产生一次新的commit来处理 rebase 合并 git rebase b 不会产生一次合并commit 合并冲突 文本冲突\n编辑冲突文件,确认到底保留哪方的内容 然后 add → commit 操作 非文本冲突\n保留当前分支文件 git checkout --ours 文件名 保留被合并分支文件 git checkout --theirs 文件名 然后 add → commit 操作 贮藏 有时,当你在项目的一部分上已经工作一段时间后,所有东西都进入了混乱的状态, 而这时你想要切换到另一个分支做一点别的事情。 问题是,你不想仅仅因为过会儿回到这一点而为做了一半的工作创建一次提交。 针对这个问题的答案是 git stash 命令。\n创建贮藏 前提,被贮藏文件是被 暂存(add)的\n贮藏当前目录全部文件 1 git stash 贮藏某个文件 1 git stash push filename 查看贮藏的东西 1 git stash list 恢复贮藏 不指定贮藏名,默认最近的 1 git stash apply 指定贮藏名 1 git stash apply stash@{2} 删除贮藏 直接删除 1 git stash drop stash@{2} 应用贮藏然后立即从栈上扔掉它 1 git stash pop stash@{2} 其余贮藏相关操作详见 链接\n","date":"2024-08-24","permalink":"https://hobocat.github.io/post/tool/git-use/","summary":"开始一个新的项目 初始化 1 git init 添加remote 1 git remote origin add \u0026lt;url\u0026gt; 添加文件 1 git add 提交 1 git commit -m \u0026#34;注释\u0026#34; 同步 远端拉取 1 git push -u origin \u0026lt;branchName\u0026gt; 远端推送 1 git pull origin \u0026lt;branchName\u0026gt; 查看日志和状","title":"git use"},]

[{"content":"用户分类 git 用户分类 global (全局) local(仓库)级别 优先级 local \u0026gt; global 全局配置 查看配置 1 git config --list 清空全局 user.name email 1 2 git config --global --unset user.name git config --global --unset user.email 设置全局 user.name email 1 2 git config --global user.name \u0026#34;hobocat\u0026#34; git config --global user.email \u0026#34;hobocat@126.com\u0026#34; 本地配置 配置单个仓库的用户信息\n清空 user.name email\n1 2 git config --unset user.name git config --unset user.email 设置 user.name email\n1 2 git config user.name \u0026#34;hobocat\u0026#34; git config user.email \u0026#34;hobocat@126.com\u0026#34; ssh 多用户配置 生成秘钥 生成命令 1 ssh-keygen -t {算法名} -f {文件路劲及文件名} -c \u0026#34;解释信息,一般是邮箱\u0026#34; 生成gitee仓库的ssh 1 ssh-keygen -t rsa -f ~/.ssh/id_rsa.gitee -c \u0026#34;hobocat@126.com\u0026#34; 生成github仓库的ssh 1 ssh-keygen -t rsa -f ~/.ssh/id_rsa.github -c \u0026#34;hobocat@126.com\u0026#34; 生成公司仓库的ssh 1 ssh-keygen -t rsa -f ~/.ssh/id_rsa.company -c \u0026#34;hobocat@126.com\u0026#34; 将 ssh-key 分别添加到 ssh-agent 信任列 1 2 3 4 ssh-agent bash ssh-add ~/.ssh/id_rsa.gitee ssh-add ~/.ssh/id_rsa.github ssh-add ~/.ssh/id_rsa.company 添加公钥到自己的 git 账户中 | 使用命令,copy公钥,到 git 账户中粘贴即可。或者打开文件复制,带 pub 的文件\n1 pbcopy \u0026lt; ~/.ssh/id_rsa.gitee.pub git平台添加ssh gitee方式 配置多平台 | 在生成密钥的.ssh 目录下,新建一个config文件,然后配置不同的仓库,\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 #default github user self host github.com hostname github.com user hobocat #默认就是git,可以不写 identityfile ~/.ssh/id_rsa.github # gitee的配置 host gitee.com # 别名,最好别改 hostname gitee.com #要连接的服务器 user hobocat #用户名 #密钥文件的地址,注意是私钥 identityfile ~/.ssh/id_rsa_gitee #add gitlab user host xxxx hostname xxxx user hobocat preferredauthentications publickey identityfile ~/.ssh/id_rsa.company ","date":"2024-08-24","permalink":"https://hobocat.github.io/post/tool/git%E5%A4%9A%E7%94%A8%E6%88%B7%E9%85%8D%E7%BD%AE/","summary":"用户分类 git 用户分类 global (全局) local(仓库)级别 优先级 local \u0026gt; global 全局配置 查看配置 1 git config --list 清空全局 user.name email 1 2 git config --global --unset user.name git config --global --unset user.email 设置全局 user.name email 1 2 git config --global user.name \u0026#34;hobocat\u0026#34; git config --global user.email \u0026#34;hobocat@126.com\u0026#34; 本","title":"git多用户配置"},]

[{"content":"docker宿主机磁盘满了处理方法 清理docker资源 删除未使用的容器 1 docker container prune 删除未使用的镜像 1 docker image prune 删除未使用的卷 1 docker volume prune 删除未使用的网络 1 docker network prune 全量清理 清理所有未使用的资源 1 docker system prune 清理未使用的镜像和卷 1 docker system prune -a --volumes 增加docker主机的存储空间 增加磁盘空间 重新分区,后迁移docker存储目录 迁移docker储存目录 docker存储目录一般存放在 /var/lib/docker 目录\n停止docker服务 1 sudo systemctl stop docker 移动存储目录 1 sudo rsync -ap /var/lib/docker /new/docker/dir 更新docker配置 编辑docker配置文件 /etc/docker/daemon.json, 添加或更新 data-root 选项。 1 2 3 { \u0026#34;data-root\u0026#34;: \u0026#34;/new/docker/dir\u0026#34; } 重启docker服务 1 sudo systemctl start docker ","date":"2024-08-22","permalink":"https://hobocat.github.io/post/docker/docker%E6%80%BB%E7%BB%93/","summary":"Docker宿主机磁盘满了处理方法 清理Docker资源 删除未使用的容器 1 docker container prune 删除未使用的镜像 1 docker image prune 删除未使用的卷 1 docker volume prune 删除未使用的网络 1 docker network prune 全量清理 清理","title":"docker总结"},]

[{"content":"","date":"2024-07-28","permalink":"https://hobocat.github.io/post/mysql/%E4%BA%8B%E5%8A%A1%E7%AF%87/","summary":"","title":"mysql事务"},]

[{"content":"安装 配置 常用命令与sql语句 sql语句的执行 ","date":"2024-07-28","permalink":"https://hobocat.github.io/post/mysql/%E5%9F%BA%E7%A1%80%E7%AF%87/","summary":"安装 配置 常用命令与SQL语句 SQL语句的执行","title":"mysql基础"},]

[{"content":"存储引擎 ","date":"2024-07-28","permalink":"https://hobocat.github.io/post/mysql/%E5%AD%98%E5%82%A8%E7%AF%87/","summary":"存储引擎","title":"mysql存储"},]

[{"content":"","date":"2024-07-28","permalink":"https://hobocat.github.io/post/mysql/%E7%B4%A2%E5%BC%95%E7%AF%87/","summary":"","title":"mysql索引"},]

[{"content":"","date":"2024-07-28","permalink":"https://hobocat.github.io/post/mysql/%E9%94%81%E7%AF%87/","summary":"","title":"mysql锁"},]

[{"content":"写一个工具类 download.js 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 /** * 下载base64格式文件 * @param {base64} data * @param {文件名} filename */ export const downloadfilebybyte = (data, filename) =\u0026gt; { const blob = buildblobbybyte(data) downloadfile(blob, filename) } /** * 将base64格式文件转为 blob * @param {base64格式} data * @returns blob */ export const buildblobbybyte = (data) =\u0026gt; { const raw = window.atob(data) const rawlength = raw.length const uint8array = new uint8array(rawlength) for (let i = 0; i \u0026lt; rawlength; ++i) { uint8array[i] = raw.charcodeat(i) } return new blob([uint8array]) } /** * 下载文件 * @param {blob文件} blob * @param {文件名} filename */ export const downloadfile = (blob, filename) =\u0026gt; { const link = document.createelement(\u0026#39;a\u0026#39;) link.href = window.url.createobjecturl(blob) link.download = filename // 此写法兼容可火狐浏览器 document.body.appendchild(link) const evt = document.createevent(\u0026#39;mouseevents\u0026#39;) evt.initevent(\u0026#39;click\u0026#39;, false, false) link.dispatchevent(evt) document.body.removechild(link) } 调用 1 2 3 4 // 注意文件位置 import { downloadfilebybyte } from \u0026#39;@/utils/download\u0026#39; downloadfilebybyte(base64str, filename) ","date":"2024-07-04","permalink":"https://hobocat.github.io/post/node/node/","summary":"写一个工具类 download.js 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 /** * 下载Base64格式文件 * @param {Base64} data * @param {文件名} fileName */ export const","title":"vue实现转存base64格式的文件下载"},]

[{"content":"常用日志框架 log4j apache log4j 是一个基于 java 的日志记录工具。它是由 ceki gülcü首创的,现在则是 apache 软件基金会的一个项目。 log4j 是几种 java 日志框架之一。 log4j 2 apache log4j 2 是 apache 开发的一款 log4j 的升级产品。 commons logging apache 基金会所属的项目,是一套 java 日志接口,之前叫 jakarta commons logging,后更名为 commons logging。 slf4j 类似于 commons logging,是一套简易 java 日志门面,本身并无日志的实现。(simple logging facade for java,缩写 slf4j)。 logback 一套日志组件的实现(slf4j 阵营)。 jul java util logging,自 java1.4 以来的官方日志实现。 日志结构框架 日志门面 门面设计模式,它只提供一套接口规范,自身不负责日志功能的实现,目的是让使用者不需要关注底层具体是哪个日志库来负责日志打印及具体的使用细节。目前使用广泛的有两种:slf4j 和 common logging\n日志实现 他具体实现了日志的相关功能,主流的三个 log4j、logback 、log-jdk。\n日志适配器 日志适配器分两种场景:桥接模式-即中间桥梁,把两方连接起来 日志门面适配器:\n因为 slf4j 是后提出来的,在此之前的日志库是没有实现 slf4j 接口的,所以额外需要一个适配器解决接口不兼容问题。\n日志库适配器:\n老的工程里,已经使用了别的日志库的 api 打印日志,要将日志库模式改为 slf4j+日志库模式,但是项目中使用老的 api 打印日志的地方太多,无法全改,此时需要一个适配器完成从就日志 api 到 slf4j 的路由,使得在不改动原有代码的情况下,升级为 slf4j 规范统一管理日志。\n为什么要用日志门面? 日志门面提供了统一接口规范,使用者只需使用门面,而不需要关心具体的实现。另一方面,项目中引入别的依赖项目或 jar,而此依赖使用别的日志框架,则会使项目变得难以维护\n常用日志框架的使用及配置 新项目推荐使用 slf4j + logback 组合 slf4j slf4j 用法\nslf4j 与其它日志组件的关系说明\nslf4j 的设计思想比较简洁,使用了 facade 设计模式,slf4j 本身只提供了一个 slf4j-api-version.jar 包,这个 jar 中主要是日志的抽象接口,jar 中本身并没有对抽象出来的接口做实现。 对于不同的日志实现方案(例如 logback,log4j\u0026hellip;),封装出不同的桥接组件(例如 logback-classic-version.jar,slf4j-log4j12-version.jar),这样使用过程中可以灵活的选取自己项目里的日志实现。 slf4j 与其它日志组件调用关系图\n项目集成\n1 2 3 4 5 6 \u0026lt;!--只有slf4j-api依赖--\u0026gt; \u0026lt;dependency\u0026gt; \u0026lt;groupid\u0026gt;org.slf4j\u0026lt;/groupid\u0026gt; \u0026lt;artifactid\u0026gt;slf4j-api\u0026lt;/artifactid\u0026gt; \u0026lt;version\u0026gt;${slf4j-api.version}\u0026lt;/version\u0026gt; \u0026lt;/dependency\u0026gt; 1 2 private static final logger log = loggerfactory.getlogger(xxx.class); // log 使用static修饰,代表跟当前类绑定,避免每次都new 一个新对象 另外,使用 slf4j+日志库模式时,一定得注意 jar 或日志库冲突问题,可能导致日志打印失效。 log4j 先于 slf4j 出现的日志实现,若想使用 slf4j 的接口规范,需要中间桥接 slf4j-log4j12\n项目集成\n1 2 3 4 5 6 7 8 9 10 \u0026lt;dependency\u0026gt; \u0026lt;groupid\u0026gt;org.slf4j\u0026lt;/groupid\u0026gt; \u0026lt;artifactid\u0026gt;slf4j-log4j12\u0026lt;/artifactid\u0026gt; \u0026lt;version\u0026gt;${slf4j-log4j12.version}\u0026lt;/version\u0026gt; \u0026lt;/dependency\u0026gt; \u0026lt;dependency\u0026gt; \u0026lt;groupid\u0026gt;log4j\u0026lt;/groupid\u0026gt; \u0026lt;artifactid\u0026gt;log4j\u0026lt;/artifactid\u0026gt; \u0026lt;version\u0026gt;${log4j.version}\u0026lt;/version\u0026gt; \u0026lt;/dependency\u0026gt; 配置文件 log4j.xml | log4j.properties\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 # [level], [appendernames] eg : debug, stdout,d,e log4j.rootlogger = debug, stdout,d,e # 配置日志信息输出目的地 log4j.appender.stdout = org.apache.log4j.consoleappender # target是输出目的地的目标 log4j.appender.stdout.target = system.out # 指定日志消息的输出最低层次 log4j.appender.stdout.threshold = info # 定义名为stdout的输出端的layout类型 log4j.appender.stdout.layout = org.apache.log4j.patternlayout # 如果使用pattern布局就要指定的打印信息的具体格式conversionpattern log4j.appender.stdout.layout.conversionpattern = [%-5p] %d{yyyy-mm-dd hh:mm:ss} %l%m%n #log4j.logger.com.camore.copy = debug,stdout # 名字为d的对应日志处理 log4j.appender.d = org.apache.log4j.dailyrollingfileappender # file是输出目的地的文件名 log4j.appender.d.file = log//app_debug.log #false:默认值是true,即将消息增加到指定文件中,false指将消息覆盖指定的文件内容 log4j.appender.d.append = true log4j.appender.d.threshold = debug log4j.appender.d.layout = org.apache.log4j.ttcclayout # 名字为e的对应日志处理 log4j.appender.e = org.apache.log4j.dailyrollingfileappender log4j.appender.e.file = log//app_error.log log4j.appender.e.append = true log4j.appender.e.threshold = error log4j.appender.e.layout = org.apache.log4j.patternlayout log4j.appender.e.layout.conversionpattern = %-d{yyyy-mm-dd hh:mm:ss} [ %t:%r ] - [ %p ] %m%n logback 与 log4j 同一作者,是 log4j 的升级,具备比 log4j 更多的优点。后于 slf4j 接口规范开发,所以直接实现了 slf4j 的接口。\nlogback 当前分为 3 个模块 logback-core,logback-classic, logback-access\nlogback-core 是其他模块的基础 logback-classic 是 log4j 的改良,本省实现了 slf4j 的接口 logback-access 访问模块与 servlet 容器集成提供通过 http 来访日志的功能 logback 组件\nlogger:日志的记录器,主要用于存放日志对象,也可以定义日志类型、级别 appender:用于指定日志输出的目的地,可以是 控制台、文件、数据库等 layout:负责把事件转成字符串,格式化的日志信息的输出。在 logback 中 layout 对象被封装成 encoder 中 项目集成\n1 2 3 4 5 6 7 8 9 10 11 \u0026lt;!--logback-classic依赖logback-core,会自动级联引入--\u0026gt; \u0026lt;dependency\u0026gt; \u0026lt;groupid\u0026gt;ch.qos.logback\u0026lt;/groupid\u0026gt; \u0026lt;artifactid\u0026gt;logback-classic\u0026lt;/artifactid\u0026gt; \u0026lt;version\u0026gt;${logback-classic.version}\u0026lt;/version\u0026gt; \u0026lt;/dependency\u0026gt; \u0026lt;dependency\u0026gt; \u0026lt;groupid\u0026gt;ch.qos.logback\u0026lt;/groupid\u0026gt; \u0026lt;artifactid\u0026gt;logback-core\u0026lt;/artifactid\u0026gt; \u0026lt;version\u0026gt;${logback-core.version}\u0026lt;/version\u0026gt; \u0026lt;/dependency\u0026gt; 配置文件 logback.groovy | logback-test.xml | logback.xml\n加载顺序 logback-test.xml \u0026gt; logback.groovy \u0026gt; logback.xml \u0026gt; basicconfigurator(默认配置)\n配置详情\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 42 43 44 45 46 47 48 49 50 51 52 53 54 55 56 57 58 59 60 61 62 63 64 65 66 67 68 69 70 \u0026lt;?xml version=\u0026#34;1.0\u0026#34; encoding=\u0026#34;utf-8\u0026#34;?\u0026gt; \u0026lt;!-- 配置文件修改时重新加载,默认true --\u0026gt; \u0026lt;configuration scan=\u0026#34;true\u0026#34;\u0026gt; \u0026lt;!--定义日志文件的存储地址 勿在 logback 的配置中使用相对路径--\u0026gt; \u0026lt;property name=\u0026#34;catalina_base\u0026#34; value=\u0026#34;**/logs\u0026#34;\u0026gt;\u0026lt;/property\u0026gt; \u0026lt;!-- 控制台输出 --\u0026gt; \u0026lt;appender name=\u0026#34;console\u0026#34; class=\u0026#34;ch.qos.logback.core.consoleappender\u0026#34;\u0026gt; \u0026lt;encoder charset=\u0026#34;utf-8\u0026#34;\u0026gt; \u0026lt;!-- 输出日志记录格式 --\u0026gt; \u0026lt;pattern\u0026gt;%d{yyyy-mm-dd hh:mm:ss.sss} [%thread] %-5level %logger{36} - %msg%n\u0026lt;/pattern\u0026gt; \u0026lt;/encoder\u0026gt; \u0026lt;/appender\u0026gt; \u0026lt;!-- 第一个文件输出,每天产生一个文件 --\u0026gt; \u0026lt;appender name=\u0026#34;file1\u0026#34; class=\u0026#34;ch.qos.logback.core.rolling.rollingfileappender\u0026#34;\u0026gt; \u0026lt;rollingpolicy class=\u0026#34;ch.qos.logback.core.rolling.timebasedrollingpolicy\u0026#34;\u0026gt; \u0026lt;!-- 输出文件路径+文件名 --\u0026gt; \u0026lt;filenamepattern\u0026gt;${catalina_base}/aa.%d{yyyymmdd}.log\u0026lt;/filenamepattern\u0026gt; \u0026lt;!-- 保存30天的日志 --\u0026gt; \u0026lt;maxhistory\u0026gt;30\u0026lt;/maxhistory\u0026gt; \u0026lt;/rollingpolicy\u0026gt; \u0026lt;encoder charset=\u0026#34;utf-8\u0026#34;\u0026gt; \u0026lt;!-- 输出日志记录格式 --\u0026gt; \u0026lt;pattern\u0026gt;%d{yyyy-mm-dd hh:mm:ss.sss} [%thread] %-5level %logger{36} - %msg%n\u0026lt;/pattern\u0026gt; \u0026lt;/encoder\u0026gt; \u0026lt;/appender\u0026gt; \u0026lt;!-- 第二个文件输出,每天产生一个文件 --\u0026gt; \u0026lt;appender name=\u0026#34;file2\u0026#34; class=\u0026#34;ch.qos.logback.core.rolling.rollingfileappender\u0026#34;\u0026gt; \u0026lt;file\u0026gt;${catalina_base}/bb.log\u0026lt;/file\u0026gt; \u0026lt;rollingpolicy class=\u0026#34;ch.qos.logback.core.rolling.timebasedrollingpolicy\u0026#34;\u0026gt; \u0026lt;filenamepattern\u0026gt;${catalina_base}/bb.%d{yyyymmdd}.log\u0026lt;/filenamepattern\u0026gt; \u0026lt;maxhistory\u0026gt;30\u0026lt;/maxhistory\u0026gt; \u0026lt;/rollingpolicy\u0026gt; \u0026lt;encoder charset=\u0026#34;utf-8\u0026#34;\u0026gt; \u0026lt;pattern\u0026gt;%d{yyyy-mm-dd hh:mm:ss.sss} [%thread] %-5level %logger{36} - %msg%n\u0026lt;/pattern\u0026gt; \u0026lt;/encoder\u0026gt; \u0026lt;/appender\u0026gt; \u0026lt;appender name=\u0026#34;custom\u0026#34; class=\u0026#34;ch.qos.logback.core.rolling.rollingfileappender\u0026#34;\u0026gt; \u0026lt;file\u0026gt;${catalina_base}/custom.log\u0026lt;/file\u0026gt; \u0026lt;rollingpolicy class=\u0026#34;ch.qos.logback.core.rolling.timebasedrollingpolicy\u0026#34;\u0026gt; \u0026lt;!-- daily rollover --\u0026gt; \u0026lt;filenamepattern\u0026gt;${catalina_base}/custom.%d{yyyy-mm-dd}.log\u0026lt;/filenamepattern\u0026gt; \u0026lt;!-- keep 30 days\u0026#39; worth of history --\u0026gt; \u0026lt;maxhistory\u0026gt;30\u0026lt;/maxhistory\u0026gt; \u0026lt;/rollingpolicy\u0026gt; \u0026lt;encoder charset=\u0026#34;utf-8\u0026#34;\u0026gt; \u0026lt;pattern\u0026gt;%d{yyyy-mm-dd hh:mm:ss.sss} [%thread] %-5level %logger{36} - %msg%n\u0026lt;/pattern\u0026gt; \u0026lt;/encoder\u0026gt; \u0026lt;/appender\u0026gt; \u0026lt;!-- 设置日志输出级别 --\u0026gt; \u0026lt;root level=\u0026#34;error\u0026#34;\u0026gt; \u0026lt;appender-ref ref=\u0026#34;console\u0026#34; /\u0026gt; \u0026lt;/root\u0026gt; \u0026lt;logger name=\u0026#34;file1\u0026#34; level=\u0026#34;debug\u0026#34;\u0026gt; \u0026lt;appender-ref ref=\u0026#34;file1\u0026#34; /\u0026gt; \u0026lt;/logger\u0026gt; \u0026lt;logger name=\u0026#34;file1\u0026#34; level=\u0026#34;info\u0026#34;\u0026gt; \u0026lt;appender-ref ref=\u0026#34;file2\u0026#34; /\u0026gt; \u0026lt;/logger\u0026gt; \u0026lt;!-- 自定义logger --\u0026gt; \u0026lt;logger name=\u0026#34;custom\u0026#34; level=\u0026#34;info\u0026#34;\u0026gt; \u0026lt;appender-ref ref=\u0026#34;custom\u0026#34; /\u0026gt; \u0026lt;/logger\u0026gt; \u0026lt;/configuration\u0026gt; ","date":"2024-07-03","permalink":"https://hobocat.github.io/post/log/java-log/","summary":"常用日志框架 Log4j Apache Log4j 是一个基于 Java 的日志记录工具。它是由 Ceki Gülcü首创的,现在则是 Apache 软件基金会的一个项目。 Log4j 是几种 Java 日志框架之一。 Log4j 2 Apache Log4j 2 是 apache 开发的一款 Log4j 的升级","title":"java log"},]

[{"content":"学习计划 加油~ 努力找个好工作 复习老的笔记知识 java系列\njava基础 多线程 集合 io | nio jvm、gc及调优 设计模式 srping | spring cloud\nspring | springboot 基础 注解及部分源码分析 spring cloud各组件 mysql\nmysql 基础 索引 事务 mq\nrocketmq kafka nosql\nredis 其他\ndocker nginx mybatis | mybatis plus 学习及总结前端笔记 node 基础 vue3 选项式api | 组合式api 组件 element | ant design 老的笔记差缺补漏 jvm调优 gc详解 算法与数据结构 网络基础 | 通信协议 leetcode刷题 边面试边学习 外语学习 英语 or 日语\n","date":"2024-07-03","permalink":"https://hobocat.github.io/study/","summary":"学习计划 加油~ 努力找个好工作 复习老的笔记知识 Java系列 Java基础 多线程 集合 IO | NIO JVM、GC及调优 设计模式 Srping | Spring Cloud Spring | SpringBoot 基础 注解及部分源码分析 Spring Cloud各","title":"study"},]

[{"content":"java 关键字 编号 名称 功能 其他 1 package 指明包路径 2 import 引入类 3 public 类/方法/属性 修饰符,公有 一种访问控制方式:共用模式,可以应用于类、方法或字段(在类中声明的变量)的访问控制修饰符。 4 private 类/方法/属性 修饰符, 私有 只有本类可以引用 一种访问控制方式:私用模式,访问控制修饰符,可以应用于类、方法或字段(在类中声明的变量) 5 rotected 类/方法/属性 修饰符,保护类型,同一包下可用 一种访问控制方式:保护模式,可以应用于类、方法或字段(在类中声明的变量)的访问控制修饰符 6 interface 接口关键字 7 class 类关键字 声明一个类,用来声明新的 java 类 8 enum 枚举关键字 9 extends 继承 类 表明一个类型是另一个类型的子类型。对于类,可以是另一个类或者抽象类;对于接口,可以是另一个接口 10 implements 实现 接口 表明一个类实现了给定的接口 11 static 类/方法/属性 修饰符,静态代码块 表明具有静态属性。类创建时加载,存在堆区 12 abstract 类/方法/变量 修饰符 表示抽象类/方法 表明类或者成员方法具有抽象属性,用于修改类或方法 13 final 类/方法/属性修饰符 不可被重新赋值 用来说明最终属性,表明一个类不能派生出子类,或者成员方法不能被覆盖,或者成员域的值不能被改变,用来定义常量 14 volitate 类/方法/属性修饰符 表示被修饰属性的内存可见性 多线程下别的线程修改的值对另一线程可见 15 transient 类/方法/属性修饰符 被修饰的属性序列化时忽略 声明不用序列化的成员域 16 native 类/方法/属性修饰符 表示方法是 c/c++实现 用来声明一个方法是由与计算机相关的语言(如 c/c++/fortran 语言)实现的 17 strictfp 类/方法/属性修饰符 用来声明 fp_strict(单精度或双精度浮点数)表达式遵循 ieee 754 算术规范 18 synchronized 类/方法/属性修饰符 同步锁 表明一段代码需要同步执行 19 new 创建新对象关键字 new 对象时分配内存空间 用来创建新实例对象 20 void 方法返回值修饰符 代表无返回值 21 return 返回语句 方法级 跳出方法 22 break 中断语句 跳出循环或当前条件 提前跳出一个块 23 continue 结束本次循环语句 回到一个块的开始处 24 for 循环语句 25 do 循环语句循环体 26 while 循环语句 条件判断 27 assert 断言 调试 28 switch 分支结构 可替换多 if 语句 如 3 个以上 29 case switch 子分支 30 default switch 默认分支 31 if 条件判断语句 32 else if 之外的条件 还可单配 else if 条件判断 33 try 异常捕获语句 try 块 要捕获异常的内容 一个 必执行 34 catch 异常捕获语句 捕获的异常类型 可 0~n 个 无异常发生不执行 35 finally 异常捕获语句 异常最后的处理 必执行 36 throw 方法内抛出一个异常语句 手动 37 throws 抛出多个异常 方法定义上 被动 38 instanceof 判断对象的类型 39 this 对象/类 本身 40 super 调用父类方法 41 null 空值 42 true 布尔值 true 43 false 布尔值 false 44 byte 基本数据类型 字节 1byte 8 位 (-2^7~2^7 -1) 45 short 基本数据类型 短整型 2byte 16 位 46 int 基本数据类型 整型 4byte 32 位(bit) 47 long 基本数据类型 长整型 8byte 64 位 48 float 基本数据类型 浮点型 单精度 4byte 32 位 49 double 基本数据类型 浮点型 双精度 8byte 64 位 50 char 基本数据类型 字符 2byte16 位 0-255 51 boolean 基本数据类型 布尔 1byte 8 位 true 1 false 0 52 const 保留字 53 var 保留字 54 goto 保留字 ","date":"2024-07-02","permalink":"https://hobocat.github.io/post/java/%E5%85%B3%E9%94%AE%E5%AD%97/","summary":"Java 关键字 编号 名称 功能 其他 1 package 指明包路径 2 import 引入类 3 public 类/方法/属性 修饰符,公有 一种访问控制方式:共用模式,可以应用于类、方法或字段(在类中声明的变量)的访问控制","title":"java关键字"},]

[{"content":"线程 几个概念 | 并行 | 并发\n并行(parallel) 多个任务同时操作多个资源,每个任务独立执行,互不影响 并发(concurrent) 多个任务同时操作同一资源,多个线程交替执行 | 进程 | 线程 | 管程\n进程(process) 操作系统上任务执行的最小单元,一个服务就是一个进程。放在java里,启动一个程序就是一个进程。\n线程(thread) 线程是比进程更小的执行单元,一个进程内包含n多个线程\n管程monitor 可以理解为锁\n线程状态 线程分为 用户线程和守护线程(damon=true) 生命周期随进程周期 如 gc 线程\nnew:新建状态,未运行 runnable:可执行状态{运行状态,待运行} blocked:阻塞状态 等待锁,然后执行 waiting:无限期等待 timed_waiting:限时等待 terminated:终止状态 线程的创建 1. 继承 thread 实际上 thread 也是实现了 runnable 接口\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 public class mythread extends thread { void run () { // 执行体 } } // 创建并运行 new mythread().start(); // 简易写法 thread a = new thread(r -\u0026gt; { // 执行体 }); // 运行 a.start(); 2. 实现 runnable 无返回值\n1 2 3 4 5 6 7 8 9 public class myrunnable implements runnable { void run(){ // 执行体 } } // 调用 new thread(new myrunnable()).start(); 3. 实现 callable 有返回值 ,获取返回值会阻塞|抛出异常\n1 2 3 4 5 6 7 8 9 10 11 public class mycallable implements callable{ v call(){ // 执行体 return null; } } // 调用 mycallable call = new mycallable (); new thread(call).start(); run() 与 start() 区别 run: 只是方法的执行体 start: 创建一个新的线程,会执行 run() 常用操作 线程停止\n1. 正常停止,即执行完run()方法\r2. 设置一个标志位,暴露public方法停止\ra. `volatile boolean flag`\rb. `atomicboolean flag`\rc. 中断操作 `thread.interrupt()`\r3. 不建议使用jdk提供的`stop()` 或 `destory()` 方法\r中断机制\n概念:停止线程的协商机制 中断标志位: interrupt=true。发起一个协商,而不是立即停止线程 常用方法: 1 2 3 4 5 6 7 8 9 // 将标志位设置为true,线程处于阻塞状态时,会抛出异常,且标志位会置为false void interrupt() // 1. 判断当前线程是否已经中断,并返回中断状态 // 2. 若线程已是中断状态,则清空状态位,并设为false thread.interrupt() // 返回中断状态位,线程正常停止的话返回false boolean isinterrupted() 线程的等待与唤醒\n1 2 3 4 5 6 7 8 9 10 11 12 13 // synchronized wait() nofity() notifyall() // lock unlock 块中 lock.newcondition().await() lock.newcondition().singal() lock.newcondition().singalall() // locksupport locksupport.park(thread thread) locksupport.unpark() 线程安全 原子性 同一个操作不能被中途打断,类似事务,要么全部完成,要么全不完成\n可见性 有一个线程变更了共享变量,主线程或其他线程需要知道变量已经变更\n有序性 指令重排问题, 编译器编译代码的过程中,会对代码执行顺序重排\nfuture 传统的创建线程方式都无法获取到异步执行结果,通过实现callback接口,并用future可以来接收多线程的执行结果。 future表示一个可能还没有完成的异步任务的结果,针对这个结果可以添加callback以便在任务执行成功或失败后作出相应的操作。\nfuture主要方法\nfuturetask\u0026lt;t\u0026gt;\n能用来包装一个callable或runnable对象,因为它实现了runnable接口,而且它能被传递到executor进行执行。为了提供单例类,这个类在创建自定义的工作类时提供了protected构造函数。\n1 2 3 4 5 futuretask\u0026lt;string\u0026gt; task = new futuretask\u0026lt;\u0026gt;(callable\u0026lt;v\u0026gt; callable); futuretask\u0026lt;string\u0026gt; task = new futuretask\u0026lt;\u0026gt;(runnable runnable, v result); // 会阻塞线程 task.get() schedualfuture\n这个接口表示一个延时的行为可以被取消。通常一个安排好的future是定时任务schedualedexecutorservice的结果\ncompletefuture\n一个future类是显示的完成,而且能被用作一个完成等级,通过它的完成触发支持的依赖函数和行为。当两个或多个线程要执行完成或取消操作时,只有一个能够成功。\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 34 35 36 37 38 39 40 41 // 1.无返回值 // 1.1 不指定线程池,使用默认线程池 forkjoinpool.commonpool completablefuture.runasync(runnable runnable) // 1.2 自定义线程池 completablefuture.runasync(runnable runnable, excutor excutor) // 2. 有返回值 // 2.1 不指定线程池,使用默认线程池 forkjoinpool.commonpool completablefuture.supplyasync(supplier\u0026lt;u\u0026gt; supplier) // 2.2 自定义线程池 completablefuture.supplyasync(supplier\u0026lt;u\u0026gt; supplier, excutor excutor) // 3结果处理 有返回值 // 3.1 串行。入参分别是上一步的处理结果,一旦发生异常,直接断路 进入异常处理方法 .thenapply(function\u0026lt;? super t,? extends u\u0026gt; fn) // 3.2 handle 是依次执行,串行。入参分别是上一步的处理结果。发生异常,并未发生断路,而是继续执行其余的handle方法和whencomplete方法 .handle(bifunction\u0026lt;? super t, throwable, ? extends u\u0026gt; fn) // 3.3 .whencomplete(biconsumer\u0026lt;? super t, ? super throwable\u0026gt; action) // 3.4 handle发生异常时并未进入该方法执行. whencomplete发生异常会调用执行异常处理 .exceptionally(function\u0026lt;throwable, ? extends t\u0026gt; fn) // 4结果处理 无返回值 /** * 1. 可以看到串行方法上一步若无返回值,则下一个方法入参为null,即结果丢失* * 2. consumer类型方法都无返回值,或许再接其他方法,上面的执行结果会丢失* * 3. consumer类型方法应在supplier类型方法之后执行 个人总结 */ .thenaccept(function\u0026lt;? super t,? extends u\u0026gt; fn) // 5. 执行速度选择 // 5.1有2任务future1和future2 applytoeither对比哪个任务先完成,则执行后续 fn future1.applytoeither(future2, function\u0026lt;? super t, u\u0026gt; fn) future1.applytoeitherasync(future2, function\u0026lt;? super t, u\u0026gt; fn) // 6. 结果合并 // 6.1 有2任务future1和future2 合并方法时,哪个任务先完成,则等待其余任务完成后执行合并任务 fn future1.thencombine(future2, bifunction\u0026lt;? super t,? super u,? extends v\u0026gt; fn) future1.thencombineasync(future2, bifunction\u0026lt;? super t,? super u,? extends v\u0026gt; fn) forkjointask\n基于任务的抽象类,可以通过forkjoinpool来执行。一个forkjointask是类似于线程实体,但是相对于线程实体是轻量级的。大量的任务和子任务会被forkjoinpool池中的真实线程挂起来,以某些使用限制为代价。\njmm java 内存模型 cpu 和内存的桥梁\r概念\njmm 是一种抽象的概念,并不真实存在,描述的是一种规范或约束。通过这个规范定义了程序中多线程下各线程之间变量的读写访问,并决定一个线程对共享变量的写入什么时候对另外的线程可见。\n共享变量\n共享变量是存在主内存中的,多线程下,访问共享变量,新的线程将会创建一个变量的副本,各自独立。若要更新主内存中共享变量的值,主要是将自己副本中的值写会主内存中。\n不同线程之间变量是独立的,不能直接访问,都需要通过主内存。\rhappen-before 约定,本质上可见性\n一个线程内,程序执行得满足约定的顺序,预期的结果。\n关键点\n1. 原子性\r2. 可见性\r3. 有序性\rvolatile关键字\n作用: 保证了有序性和可见性,不保证原子性\n可见性: 某一线程对 volatile 修饰的变量更改,会立马同步到主内存中\n有序性: volatile 修饰的变量的操作,能锁定某些代码的重排\n原子性: 多线程下可能发生写丢失\n常用场景\n线程标志位 多线程下的单例 dcl 单例(double check ) 低消耗的读 同步写 内存屏障\n即线程对资源变更的一种保护机制。java 内存模型的重排规则要求 java 编译器在生成 jvm 指令时插入特定的内存屏障指令,通过这些【屏障指令】,volatile 实现了可见性和有序性。\nvolatile 写之前的操作,都禁止重排序到 volatile 之后 volatile 读之后得操作,都禁止重排序到 volatile 之前 volatile 写之后 volatile 读,禁止重排序 内存屏障之前的所有写操作都要回写到主内存\r内存屏障之后的读操作都能获得内存屏障之前的所有写操作的最新结果\r分类\n粗分 读屏障 load memory barrier :告诉处理器在写屏障之前,将所有存储在缓存 store buffer 中的数据同步到主内存 写屏障 store memory barrier: 细分 load-load load-store store-store store-load cas(compare and swap) 概念\n比较并替换,当且仅当预期值与内存中值相同时,更新为新值;非阻塞的原子操作 硬件保证\ncas(v, a, b) 参数:v 内存地址; a 旧的预期值; b 新值\r非阻塞的原子操作(硬件保证)\n底层使用 unsafe 类,如 compareandswapint 方法,底层使用汇编 atomic::cmpchg 命令,保证了其是原子操作\n自旋\n多线程下,跟获取锁类似,需要先获取到资源,才可执行 +1 操作。若没获取到,则自旋一次,再次尝试,直到成功。\n例 new atomicinteger.getandincrement()\n自旋锁\n详见锁篇章\n缺点\n自旋带来的资源浪费 aba 问题(偷梁换柱):解决方案\u0026mdash;带版本号判断, atomicstamprefrence aba 问题\n产生原因:compare 比较值和替换结果,cas 只检查最终的结果,而不关心中间的过程,中间过程中发生了什么不清楚\n举例\n目的 cas(1, 3) ,中间出现 cas(1, 0) → cas(0, 2) → cas(2, 1)\r解决方案, 加版本号对比\r原子类 java.util.consurrent.atomic 包下类\n工具类 locksupport\n线程阻塞工具类,本身就持有锁,最多一个许可证,不会累计 | 单一开关式\r1 2 3 4 5 6 // 发放许可证 locksupport.unpark(thread); // 获取通行证 locksupport.park(); locksupport.park(thread); semaphore\n计数信号量 维护一组许可证| 坑位抢占式\r1 2 3 4 5 6 7 8 9 10 // 每个人都 acquire 会阻止,直到获得许可证,然后拿走它。 // 每个都 release 增加了一个许可证,可能会释放一个阻止的收购方。 // 但是,没有使用实际的许可对象;只是 semaphore 保留可用数量的计数并采取相应的行动。 private final semaphore available = new semaphore(max_available, true); // 通常用于限制可以访问某些(物理或逻辑)资源的线程数 // 从信号量获取许可,阻塞,直到一个信号量可用或线程 中断。 void acquire() // 释放许可证,将其返回到信号量。 void release() cyclicbarrier\n循环屏障 | 分片处理型\r1 2 3 4 5 6 7 // 等到 各方 都援用这个 await 屏障 int await() // 所有线程都到达await()方法 cyclicbarrier barrier = new cyclicbarrier(7, ()-\u0026gt; { system.out.println(\u0026#34;所有parties都完成了,该结束了\u0026#34;); }); countdownlatch\n一种同步辅助工具,它允许一个或多个线程等待,直到在其他线程中执行的一组操作完成。\r1 2 3 4 5 6 7 8 9 10 11 12 // 阻塞 等待计数器减到0 // 计数器减到0 或 超时 boolean await(long timeout, timeunit unit) // 一直阻塞,直到计数器减为0 // 使当前线程等待,直到闩锁倒计时为零,除非线程中断。 void await() // 递减闩锁的计数,如果计数达到零,则释放所有等待的线程。 // 如果当前计数大于零,则递减。如果新计数为零,则重新启用所有等待线程以进行线程调度。 // 如果当前计数等于零,则不会发生任何反应。 // 计数器减1 void countdown() blockingqueue\n阻塞队列\r1 2 3 4 5 6 7 8 9 10 11 12 // 不阻塞,返回异常 add() 添加元素到队列,若队列已满,则抛出异常 remove() 获取并删除元素,若独立已空,则抛出异常 // 不阻塞 offer() 若添加失败,则返回false poll() 获取头元素,获取失败则返回null // 阻塞 put() 添加时若队列已满,则一直等待 take() 获取时,若队列已空,则一直等待 锁 主要解决问题:串行 并行 数据安全问题\n什么是锁 多线程环境下,存在资源抢占问题,可能出现多个线程同时访问同一资源而导致的数据不一致或异常情况,为了保证共享资源的安全性,就出现了锁。\n锁是用于控制多个线程对共享资源访问的机制。\n锁-锁的是什么 8大锁 锁类模版\n1 2 3 4 5 6 public class a { // 静态方法 使用了 synchronized修饰, 则锁住的的是类模板 public synchronized static void method() { system.out.println(\u0026#34;\u0026#34;); } } 1 2 3 4 5 6 7 8 9 public class a { // 静态方法 public static void method() { // 此处锁的也是类模板 synchronized(this){ system.out.println(\u0026#34;此处锁的也是类模板\u0026#34;); } } } 锁方法的调用对象\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 public class a { // 普通方法 使用了 synchronized修饰, 则锁住的的是方法的调用对象 即类的实例对象 public synchronized void method() { system.out.println(\u0026#34;\u0026#34;); } } a a = new a(); // a调用锁a a.method(); a b = new a(); // b调用锁b b.method(); 锁变量\n1 2 3 4 5 6 7 8 9 10 11 12 public class a { private int index = 0; public void method() { // 此处锁住的是index变量 synchronized(index) { // 代码块中执行对index的操作 system.out.println(\u0026#34;\u0026#34;); } } } 锁对象\n1 2 3 4 5 6 7 8 9 10 11 public class a { public void method() { // 此处锁住的是this对象,即 a的实例 synchronized(this) { // 代码块中执行对index的操作 system.out.println(\u0026#34;\u0026#34;); } .... } } 锁分类及概念 按线程是否阻塞可分为 有锁(悲观锁) 和 无锁(乐观锁)\n按线程是否共享分为 共享锁(读锁) 和 排它锁(写锁)\n按竞争性可分为 公平锁 和 非公平锁\n按锁状态划分为 偏向锁 | 轻量级锁 | 重量级锁\n按递归性 分为 递归锁(可重入锁)\n问题 加锁会影响性能,使并行改为串行。因此在实际的使用中,根据场景的不同,要合理的控制锁的粒度,尽量减少性能的开销,线程的阻塞等。这个过程,也就是锁的优化,jdk7 以上自带锁的膨胀与消除,即在加锁的情况下,编译器会自动根据实际情况进行锁的消除或膨胀,如不会产生竞争的情况加锁了,会自动消除锁,避免性能损耗;\n分布式锁 以上锁均为本地锁,即在同一个 jvm 中有效,而在不同的 jvm 中无效\n在集群环境中,就需要使用分布式锁来保证资源的统一\n分布式锁详见 分布式锁\n此处做简单总结\n目前常用的分布式锁\n基于 redis 的 set nx 的简易分布式锁。 原理:利用 redis 的 set nx(当不存在的时才设置成功,存在则不成功) 特性,实现简易的分布式锁。 缺点: 不可重入: 不可重试:无法重试,加锁失败即刻返回 超时释放问题:业务卡死或者服务器宕机,锁一直无法释放,卡死了 主从一致问题:主节点宕机,从节点转变为主,锁数据还未同步到该从节点,锁丢失 可在获取锁之后在设置超时时间,但不是原子操作了。 redisson 基于 redis 的分布式锁 实现原理也是基于 redis 的原子操作,使用 lua 脚本实现。 它的功能更加完善,主要有以下优点:\n对锁设置了自动过期时间,避免了因为服务器宕机而导致的锁无法释放问题。 采用哨兵机制看门狗超时续约,1 中对锁设置了过期时间,而过期时间的设置又与业务代码的执行时间有关,假若业务代码执行时长大于锁的过期时间,会造成锁的提前释放;使用看门狗模式,就避免了这种情况。看门狗原理:看门狗在每隔一段时间会检测业务代码是否执行完,若没完则续期过期时间,知道业务代码执行完毕。此时也有问题,若业务代码出现异常卡死,则会造成死锁,锁一直无法释放,这时会有一个最大等待时间,过了这个时间,锁同样也会自动释放。 可以设置最大等待时间,过期锁自动释放。即 2 中最后提到的问题。 实现了可重入功能:使用 hash 结构,存储了重入次数及当前线程标识,同一线程每获取一次锁,重入次数加一。释放一次减一。到 0 就是彻底释放了。 实现了可重试功能:利用消息订阅与信号量机制,在约定时间内多次获取锁。 multilock:解决了主从一致问题。同时向多个节点获取锁,所有节点获取成功,才算锁成功。 线程安全的集合 juc下的类\nblockingqueue blockingdeque linkedblockingqueue concurrentlinkedqueue concurrenthashmap copyonwritearraylist copyonwritearrayset 常用线程类 1 2 3 4 5 6 7 8 9 10 futuretask\u0026lt;t\u0026gt; completabledfuture\u0026lt;t\u0026gt; cyclicbarrier countdownlatch locksupport semaphore blockingqueue exchanger 线程池 概念 线程池状态 线程池创建方法 7大参数\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 threadpoolexcutor pool = threadpoolexecutor( int corepoolsize, // 线程池初始化大小 核心线程数 int maximumpoolsize, // 最大线程数 long keepalivetime, // 当线程数大于核心数时,这时多余的空闲线程在终止之前等待新任务的最长时间。 timeunit unit, // keepalivetime 单位 blockingqueue\u0026lt;runnable\u0026gt; workqueue, // 等待队列 threadfactory threadfactory, // 执行程序创建新线程时使用的工厂 rejectedexecutionhandler handler) // 拒绝策略 最大线程数 = 最大线程数 + 等待队列大小 // corepoolsize 线程池初始化大小 核心池大小是保持活动状态(并且不允许超时等)的最小工作线程数 // maximumpoolsize最大线程数 // keepalivetime 等待工作的空闲线程的超时(以纳秒为单位)。当存在超过 corepoolsize 或 allowcorethreadtimeout 时, 线程将使用此超时。否则,他们将永远等待新的工作。 // workqueue 常见线程池 4大方法\n1 2 3 4 5 executors.newfixedthreadpool(5); // 固定线程数 executors.newsinglethreadexecutor(); // 单线程 executors.newcachedthreadpool(); // 缓存线程池 executors.newworkstealingpool(); // executors.newscheduledthreadpool(3); // 定时任务线程池 ","date":"2024-07-02","permalink":"https://hobocat.github.io/post/java/java%E5%A4%9A%E7%BA%BF%E7%A8%8B/","summary":"线程 几个概念 | 并行 | 并发 并行(parallel) 多个任务同时操作多个资源,每个任务独立执行,互不影响 并发(concurrent) 多个任务同时操作同一资源,多个线","title":"java多线程基础篇"},]

[{"content":"种类 list、list\u0026lt;object\u0026gt; 、list\u0026lt;?\u0026gt; 、list\u0026lt;t\u0026gt;、list\u0026lt;? extend t\u0026gt;、list\u0026lt;? super t\u0026gt;\n1. list\u0026lt;object\u0026gt; 与无泛型 list 差不多,都可往里 add 任何对象,但意义不大,只能往里 add,取出遍历往往出现类型错误\n2. list\u0026lt;?\u0026gt; 泛型不确定的集合,一般用来接收不能确定泛型的集合\n**3. 重点区分 list\u0026lt;? extend t\u0026gt;、list\u0026lt;? super t\u0026gt; **\n功能/类型 list\u0026lt;? extend t\u0026gt; list\u0026lt;? super t\u0026gt; 特性 get first put first 实际存储内容 t 及 t 子类对象, null 1. 初始化时接受 t 及 t 子类型的 list。\n2. 不能 add t 及 t 子类对象,t 的父类对象,null 1. 初始化时可接受父类类型的 list。 2. add 操作时只能添加 t 及 t 子类对象 get 功能 获取到的值强转为 t,子类对象丢失泛型\nt t = list.get(0); 获取到对象类型为 object,所有对象丢失类型\nobject o = list.get(0); put 功能 除 null 外,其余对象均不能被 add 可 put 对象:null,t 及 t 子类对象 集合值接收(初始化) t 及 t 子类类型的 list 可赋值给该泛型 list t 及 t 父类类型的 list 可赋值给该泛型 list pecs 常用来做结果接收 producer extend 常用来做参数 consumer super ","date":"2024-07-02","permalink":"https://hobocat.github.io/post/java/java%E6%B3%9B%E5%9E%8B/","summary":"种类 List、List\u0026lt;Object\u0026gt; 、List\u0026lt;?\u0026gt; 、List\u0026lt;T\u0026gt;、List\u0026lt;? extend T\u0026gt;、List\u0026lt;? Super","title":"java泛型"},]

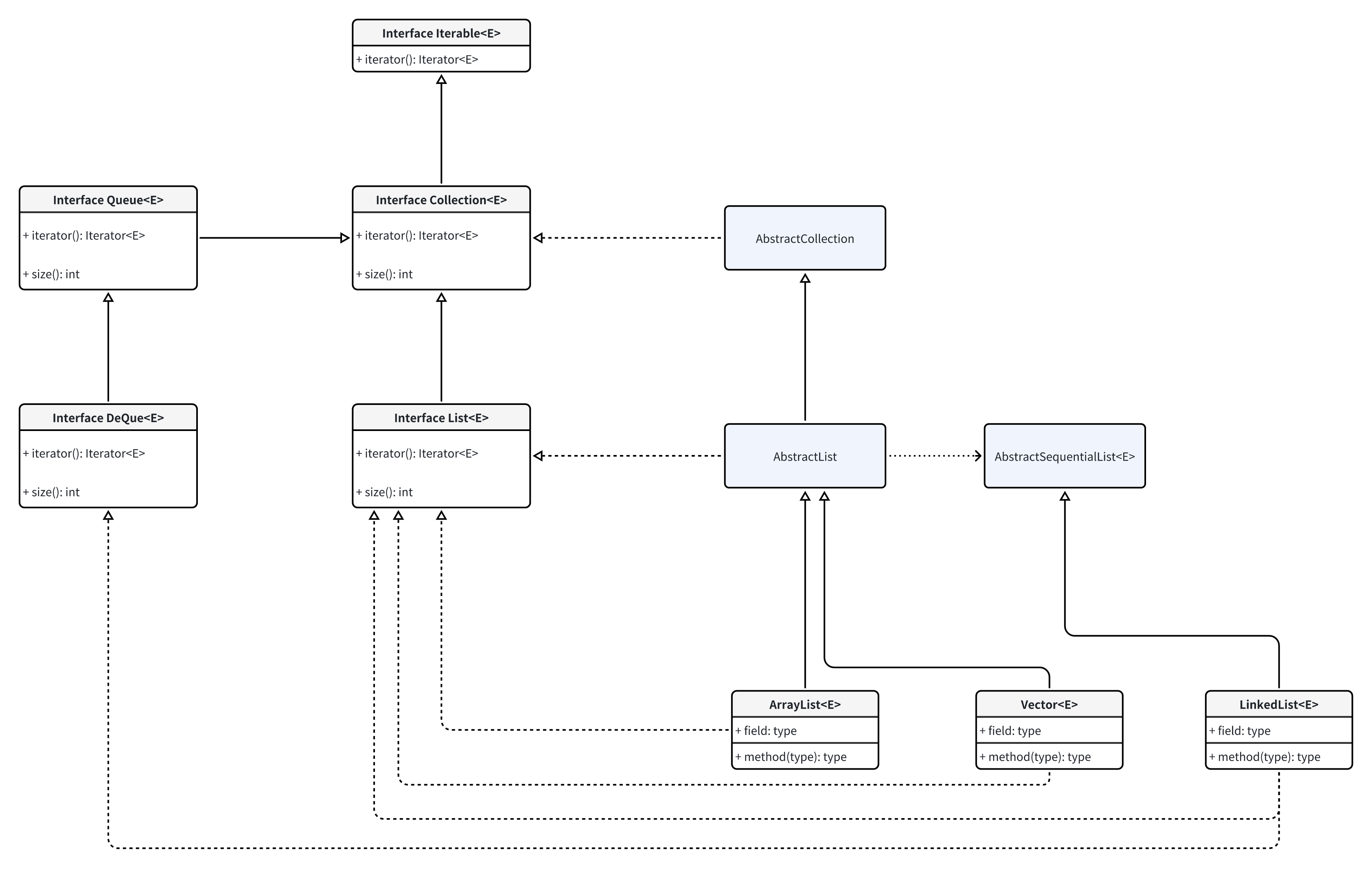

[{"content":"一、集合框架图 二、list 1、 概述 list 是一种有序列表,有明确的第一个元素、最后一个元素、上一个元素和下一个元素。\rlist 的行为和数组几乎一致:list 内部按照放啊如元素的先后顺序存放,每个元素都可以通过索引确定元素的位置,list 的索引和数组一样,从 0 开始。 list 可以添加重复元素、null 等 遍历尽量使用遍历器 iterator 进行遍历,效率高。for each 默认实现了 iterator 迭代器遍历。\n\r2、 arraylist 查询快、增删慢;自动扩容(1.5 倍);线程不安全; arraylist 底层使用数组实现,在新添或删除一个元素时,都需要通过数组的移动来完成,如下图 初始化时最好设置初始化值,默认大小 10 。因为结构底层使用数组存储,数组是不可变长度的,当空闲元素填充满了时,需要扩充空间原有容量大小的 1.5 倍,每次扩展容都需创建一个新数组,然后进行数组的拷贝,会消耗性能(时间、空间)\n3、 linkedlist (有序) 线程不安全 增删效率高,检索效率低;空间占用率高;可作为队列、栈来使用\r单向链表存储结构如下 linkedlist 是通过双向链表实现,结构如下 三、 queue 队列\n队列 fifo(first input first output) 先进先出\n队列元素只能添加到末尾;只能从头部去除元素;能添加 null,但是避免添加 null\n队列示意图 队列操作方法对比\n操作 抛异常 返回false或null 添加元素到队尾 add(e e) boolean offer(e e) 取队首元素并删除 e remove() e poll() 取队首元素但不删除 e element() e peek() 栈\n栈 stack filo (first input last output)先进后出 or (last in first out)后进先出\n栈只有入栈 push 和出栈 pop2 种操作 peek()取栈顶而不弹出\n栈示意图 java 种没有 stack 接口,一般将 deque 来模拟 stack 使用。只调用 push() pop() peek() 方法来模拟\n使用实例 中缀表达式计算 1 + 3 * (9 - 2)、进制转换\n四、set 五、map map\u0026lt;k, v\u0026gt; 是一种键值映射表\r1. hashmap 数组+链表实现 不指定初始化大小时 默认 16,加载因子 0.75(即空间再次扩容的判断依据。threshold=table.length * loadfactor),第一次 put 时初始化 table ; size \u0026gt;= threshold(size 为 map 种 entry 的实际个数)时 ,需要扩容,扩容到 table.length 的 2 倍\njdk1.8 之后,若某一节点链表元素超过 8 个,同时 table.length \u0026gt; 64,则将链表转为红黑树。红黑树相关内容详见算法与数据结构树内容。\n2. linkedhashmap 3. treemap 4. concurrenthashmap ","date":"2024-07-02","permalink":"https://hobocat.github.io/post/java/java%E9%9B%86%E5%90%88/","summary":"一、集合框架图 二、List 1、 概述 List 是一种有序列表,有明确的第一个元素、最后一个元素、上一个元素和下一个元素。 list 的行为和数组几乎一致:list 内部按照放啊如元素","title":"java集合"},]

[{"content":"1. jvmjdk\u0026amp;jre\u0026amp;jvm之间的关系 jdk包含jre和jvm,jre包含jvm javac用于编译java代码到字节码文件 使用java命令启动jvm,字节码最终运行在jvm上 内存结构 内存结构图 jvm 内存共分为 5 个区:java 虚拟机栈、本地方法栈、堆、程序计数器、方法区(元空间)\r程序计数器\n 程序计数器是一块比较小的内存空间,可以看作当前线程字节码所执行的行号指示器。属于线程独占区。如果线程执行的是java方法,则计数器的值是正在执行的字节码指令的地址。如果线程执行的是native方法,则计数器的值为undefined。\n本地方法栈\n\t本地方法栈为虚拟机执行native服务,结构和虚拟机栈完全相同。用于管理本地方法的调用,里面并没有我们写的代码逻辑,其由 native 修饰,由 c 语言实现。\n虚拟机栈\n虚拟机栈描述的是java方法执行的动态内存模型\n栈帧:每个方法执行都会创建一个栈帧,栈帧伴随着方法的创建到执行完成,用于存储局部变量表、操作数栈、动态链接、方法出口等(栈里面存的是地址,实际指向的是堆里面的对象) 局部变量表:用于保存方法的参数及局部变量,局部变量表内存空间大小在编译时期固定,在运行过程中不会改变局部变量表的大小 操作数栈:主要保存计算过程的中间结果,同时作为计算过程中变量临时的存储空间 java堆 存放对象的实例、垃圾收集器管理的主要区域。 java 虚拟机中内存最大的一块,是被所有线程共享的,几乎所有的对象实例都在这里分配内存;\n方法区\n\t属于线程共享区,存储了虚拟机加载的类信息【版本、字段、方法、接口】、运行时常量池【字面量和符号引用】、静态变量、即时编译器编译后的代码等数据。在hotspot中方法区是使用永久代实现的,所以永久代等于方法区。这里很少进行垃圾回收。\n从java8开始hotspots使用元空间取代了永久代,永久代物理是是堆的一部分而元空间属于本地内存。元空间存储类的元信息,静态变量和常量池等并入堆中。相当于永久代的数据被分到了堆和元空间中。\n直接内存【并非jvm规范定义的区域,不属于虚拟机运行时内存的一部分】\n\tjdk1.4为了弥补io缺陷引入nio,运行直接在堆外分配内存,不受jvm制约,由操作系统分配。\n线程私有、公有\n线程全局共享的区域:\n堆 方法区 线程私有:每个线程在开辟、运行的过程中会单独创建这样的一份内存,有多少个线程可能有多少个内存java\n虚拟机栈 本地方法栈 程序计数器是线程私有的 栈虽然方法运行完毕了之后被清空了,但是堆上面的还没有被清空,所以引出了 gc(垃圾回收),不能立马删除,因为不知道是否还有其它的也是引用了当前的地址来访问的\n性能调优 2. 类加载机制 一个java对象的创建过程往往包括两个阶段:类初始化阶段 和 类实例化阶段\n\t类的加载:代表jvm将java文件编译成class文件后,以二进制流的方式存放到运行时数据的方法区中,并在java的堆中创建一个java.lang.class对象,用来指向存放在方法堆中的数据结构。且虚拟机加载class文件是懒加载机制。\n类的加载 通过一个类的全限定名来获取定义此类的二进制字节流 文件方式【class文件、jar文件】 网络 程序生成【动态代理】 其它【jsp-会转换为servlet,数据库】 将这个字节流所代表的静态存储结构转化为方法区的运行时数据结构 在内存中生成一个代表这个类的class对象,作为这个类的各种数据的访问入口 类的验证 \t验证是连接的第一步,但是并非是必须的。这一阶段的目的是为了确保class文件的字流中包含的狺息符合当前虚拟机的要求,并且不会危害虚拟机自身的安全包含:\n文件格式验证 是否以魔数0xcaffebabe开头 主次版本号是否在虚拟机处理范围内 常量池中的常量是否有不被支持的常量类型 指向常量的各种索引值是否有指向不存在的常量 元数据验证 这个类是否有父类 这个类的父类是否继承不被允许的类(final修饰的类) 如果这个类不是抽象类,是否实现了接口要求实现的方法 类中的字段,方法是否与父类矛盾(例如出现不符合规则的方法重载) 字节码验证 保证任何时刻操作数栈的数据类型与指令代码序列能配合工作 保证跳转指令不会跳转到方法体以外的字节码指令 保证方法体中类型转换有效,如避免出现将父类对象赋值到子类数据类型上 符号引用验证 符号引用中通过字符串描述的全限定名是否能找到对应的类 在指定类中是否存在符合方法的字段描述符号 符号引用的类,字段,方法的访问性是否可以被当前类访问 类的准备 \t准备阶段正式为类的静态变量分配内存并设置变量的初始值。这些变量使用的内存都将在方法区中进行分配。设置的初始值并非我们指定的值而是这种变量的默认值,但是如果是被final修饰的常量则会被初始为我们指定的值\n类的解析 \t**解析阶段是将常量池中的符号引用替换为直接引用的过程。**在进行解析之前需要对符号引用进行解析,不同虚拟机实现可以根据需要判断到底是在类被加载器加载的时候对常量池的符号引用进行解析(也就是初始化之前),还是等到一个符号引用被使用之前进行解析(也就是在初始化之后)。如果一个符号引用进行多次解析请求,虚拟机中除了invokedynamic指令外,虚拟机可以对第一次解析的结果进行缓存(在运行时常量池中记录引用,并把常量标识为一解析状态),这样就避免了一个符号引用的多次解析。\n类或者接口解析\n要把一个类或者接口的符号引用解析为直接引用,需要以下三个步骤\n如果该符号引用不是一个数组类型,那么虚拟机将会把该符号代表的全限定名称传递给类加载器去加载这个类。这个过程由于涉及验证过程所以可能会触发其他相关类的加载\n如果该符号引用是一个数组类型,并且该数组的元素类型是对象。我们知道符号引用是存在方法区的常量池中的,该符号引用的描述符会类似”[java/lang/integer”的形式,将会按照上面的规则进行加载数组元素类型,如果描述符如前面假设的形式,需要加载的元素类型就是java.lang.integer ,接着由虚拟机将会生成一个代表此数组对象的直接引用\n如果上面的步骤都没有出现异常,那么该符号引用已经在虚拟机中产生了一个直接引用,但是在解析完成之前需要对符号引用进行验证,主要是确认当前调用这个符号引用的类是否具有访问权限,如果没有访问权限将抛出java.lang.illegalaccess异常\n字段解析\n对字段的解析需要首先对其所属的类进行解析,因为字段是属于类的,只有在正确解析得到其类的正确的直接引用才能继续对字段的解析。对字段的解析主要包括以下几个步骤:\n如果该字段符号引用就包含了简单名称和字段描述符都与目标相匹配的字段,则返回这个字段的直接引用,解析结束 否则,如果在该符号的类实现了接口,将会按照继承关系从下往上递归搜索各个接口和它的父接口,如果在接口中包含了简单名称和字段描述符都与目标相匹配的字段,那么久直接返回这个字段的直接引用,解析结束 否则,如果该符号所在的类不是object类的话,将会按照继承关系从下往上递归搜索其父类,如果在父类中包含了简单名称和字段描述符都相匹配的字段,那么直接返回这个字段的直接引用,解析结束 否则,解析失败,抛出java.lang.nosuchfielderror异常 如果最终返回了这个字段的直接引用,就进行权限验证,如果发现不具备对字段的访问权限,将抛出java.lang.illegalaccesserror异常\n类方法解析\n进行类方法的解析仍然需要先解析此类方法的类,在正确解析之后需要进行如下的步骤:\n类方法和接口方法的符号引用是分开的,所以如果在类方法表中发现class_index(类中方法的符号引用)的索引是一个接口,那么会抛出java.lang.incompatibleclasschangeerror的异常 如果class_index的索引确实是一个类,那么在该类中查找是否有简单名称和描述符都与目标字段相匹配的方法,如果有的话就返回这个方法的直接引用,查找结束 否则,在该类的父类中递归查找是否具有简单名称和描述符都与目标字段相匹配的字段,如果有,则直接返回这个字段的直接引用,查找结束 否则,在这个类的接口以及它的父接口中递归查找,如果找到的话就说明这个方法是一个抽象类,查找结束,返回java.lang.abstractmethoderror异常 否则,查找失败,抛出java.lang.nosuchmethoderror异常 如果最终返回了直接引用,还需要对该符号引用进行权限验证,如果没有访问权限,就抛出java.lang.illegalaccesserror异常\n接口方法解析\n同类方法解析一样,也需要先解析出该方法的类或者接口的符号引用,如果解析成功,就进行下面的解析工作:\n如果在接口方法表中发现class_index的索引是一个类而不是一个接口,那么也会抛出java.lang.incompatibleclasschangeerror的异常\n否则,在该接口方法的所属的接口中查找是否具有简单名称和描述符都与目标字段相匹配的方法,如果有的话就直接返回这个方法的直接引用。\n否则,在该接口以及其父接口中查找,直到object类,如果找到则直接返回这个方法的直接引用\n否则,查找失败\n类的初始化 初始化时机 对于初始化阶段,虚拟机规范严格规定了有且只有5种情况必须对类进行初始化(加载、验证、准备自然需在此之前开始):\n①遇到new、getstatic、putstatic、invokestatic这四条字节码指令时,如果类没有进行过初始化,则需要先触发其初始化。生成这四条指令的最常见的java代码场景是:\n使用new关键字实例化对象的时候\n读取或设置一个类的静态字段【被final修饰己在编译器把结果放入常量池的静态字段除外】\n调用一个类的静态方法的时候\n②使用java.lang.reflect包的方法对类进行反射调用的时,如果类没有进行过初始化则需要先触发其初始化\n③当初始化一个类的时候,如果发现其父类还没有进行过初始化,则需要先触发其父类的初始化\n④当虚拟机启动时,用户需要指定一个要执行的主类(包含main()方法的那个类),虚拟机会先初始化这个主类\n⑤当使用jdk7动态语言支持时,如果methodhandle实例最后的解析结果ref_getstatic、ref_putstatic、ref_invokestatic的方法句柄,并且这个方法句柄所对应的类没有进行初始化,则需要先出触发其初始化\n不执行初始化的例子\n调用类常量【public static final】 通过数组定义来引用类【base[] car = new base[5]】 通过子类引用父类的静态字段【base.parentvariable】时,子类不会被初始化 初始化过程 \t类初始化时类加载过程的最后一步,前面的类加载过程中,除了在加载阶段(类加载过程的一个阶段)应用程序可以通过自定义类加载器参与之外,其余动作完全由虚拟机主导和控制。到了初始化阶段,才真正开始执行类中定义的java程序代码。初始化阶段是执行类构造器\u0026lt;clinit\u0026gt;()方法的过程。\n\u0026lt;clinit\u0026gt;()方法执行过程中可能会影响程序运行行为:\n\u0026lt;clinit\u0026gt;()方法是由编译器自动收集类中的所有类变量的赋值动作和静态语句块中的语句合并产生的,编译器收集的顺序是由语句在源文件中出现的顺序所决定的,静态语句块中只能访问到定义在静态语句块之前的变量,定义在它之后的变量,在前面的静态语句块中可以赋值,但不能访问,属于非法向前引用。\n1 2 3 4 5 6 7 8 public class test { static { v = 3; system.out.println(v);\t//编译报错,只能赋值不能访问 } static int v = 1; } // 顺序执行最后v的值为\u0026#34;1\u0026#34; \u0026lt;clinit\u0026gt;()方法与类的构造函数(即类的实例构造器\u0026lt;init\u0026gt;()方法)不同,它不需要显式地调用父类构造器,虚拟机会保证在子类的\u0026lt;clinit\u0026gt;()方法执行之前,父类的\u0026lt;clinit\u0026gt;()方法已经执行完毕。因此在虚拟机中第一个被执行的\u0026lt;clinit\u0026gt;()方法一定是java.lang.object\n\u0026lt;clinit\u0026gt;()方法对于类(抽象类)或接口来说并不是必需的,如果一个类中没有静态语句块,也没有对变量的赋值操作,那么编译器可以不为这个类生成\u0026lt;clinit\u0026gt;()方法\n接口中不能使用静态语句块,但仍然有变量初始化的赋值操作,因此接口与类一样都会生成\u0026lt;clinit\u0026gt;()方法。但接口与类不同的是,执行接口的\u0026lt;clinit\u0026gt;()方法不需要先执行父接口的\u0026lt;clinit\u0026gt;()方法。只有当父接口中定义的变量使用时,父接口才会初始化。另外,接口的实现类在初始化时也一样不会执行接口的\u0026lt;clinit\u0026gt;()方法\n虚拟机会保证一个类的\u0026lt;clinit\u0026gt;()方法在多线程环境中被正确的加锁,同步,如果多个线程同时去初始化一个类,那么只会有一个线程去执行这个类的\u0026lt;clinit\u0026gt;()方法,其他线程都需要阻塞等待,直到活动线程执行\u0026lt;clinit\u0026gt;()方法完毕。在实际应用中这种阻塞引起的问问往往是很隐蔽\n类加载器的种类 启动(bootstrap)类加载器\n\t启动类加载器主要加载的是jvm自身需要的类,这个类加载使用c++语言实现的,是虚拟机自身的一部分,它负责将 /lib路径下的核心类库或-xbootclasspath参数指定的路径下的jar包加载到内存中。它本身是虚拟机的一部分,所以它并不是一个java类,也就是无法在java代码中获取它的引用。即extension classloader的代码中的parent为null\n注意必由于虚拟机是按照文件名识别加载jar包的,如rt.jar,如果文件名不被虚拟机识别,即使把jar包丢到lib目录下也是没有作用的(出于安全考虑,bootstrap启动类加载器只加载包名为java、javax、sun等开头的类)\n扩展(extension)类加载器\n\t扩展类加载器是指sun公司实现的sun.misc.launcher$extclassloader类,由java语言实现的,是launcher的静态内部类,它负责加载/lib/ext目录下或者由系统变量-djava.ext.dir指定位路径中的类库,开发者可以直接使用标准扩展类加载器。\n系统(system)类加载器\n\t也称应用程序加载器是指 sun公司实现的sun.misc.launcher$appclassloader。它负责加载系统类路径java -classpath或-d java.class.path 指定路径下的类库,开发者可以直接使用系统类加载器,一般情况下该类加载是程序中默认的类加载器,通过classloader#getsystemclassloader()方法可以获取到该类加载器。\n自定义(custom)类加载器\n\t自定义类加载器由第三方实现,建议满足双亲委派模式。\n只有被同一个类加载器加载的类才会相等,相同的字节码被不同的类加载器加载的类不相同。\n双亲委派模式 \t双亲委派模式要求除了顶层的启动类加载器外,其余的类加载器都应当有自己的父类加载器【并非继承】采用组合关系来复用父类加载器的相关代码,类加载器间的关系如下:\n3. 对象初始化机制 对象创建过程 对象内存分配方式 指针碰撞\n\t假设java堆中内存是绝对规整的,所有用过的内存都放在一边,空闲的内存放在另一边,中间放着一个指针作为分界点的指示器,那所分配内存就仅仅是把那个指针向空闲空间那边挪动一段与对象大小相等的距离,这种分配方式称为指针碰撞\n空闲列表\n\t如果java堆中的内存并不是规整的,已使用的内存和空闲的内存相互交错,那就没有办法简单地进行指针碰撞了,虚拟机就必须维护一个列表,记录上哪些内存块是可用的,在分配的时候从列表中找到一块足够大的空间划分给对象实例,并更新列表上的记录,这种分配方式称为空闲列表\n具体是使用空闲列表还是指针碰撞需要根据内存状况决定\n多线程内存分配管理 \t不管使用哪种对象内存分配方式,在多线程环境时,如果一个线程正在给a对象分配内存,指针还没有来的及修改,其它为b对象分配内存的线程,而且还是引用这之前的指针指向,这样会带来分配问题。于是有两种处理方式。\n分配时加锁\n\t堆是jvm中所有线程共享的,因此在其上进行对象内存的分配均需要进行加锁,这也导致了new对象的开销是比较大的。\ntlab【线程本地分配缓存区】\n\t为了提升对象内存分配的效率,对于所创建的线程都会分配一块独立的空间tlab(thread local allocation buffer),其大小由jvm根据运行的情况计算而得,在tlab上分配对象时不需要加锁,因此jvm在给线程的对象分配内存时会尽量的在tlab上分配,在这种情况下jvm中分配对象内存的性能和c基本是一样高效的,但如果对象过大的话则仍然是直接使用堆空间分配。\n\tjvm在内存新生代eden space中开辟了一小块线程私有的区域称作tlab。默认设定为占用eden space的1%。\n对象的结构 对象头\n_mark:用于存储对象自身的运行时数据,如哈希码(hashcode)、gc分代年龄、锁状态标志、线程持有的锁、偏向线程id、偏向时间戳等,称之为“markword” _klass:指向类元数据的指针 _length:数组长度(只有数组对象有) 实例数据\n\t存储在程序代码中所定义的各种类型的字段内容\n对齐填充\n\t帮助对象凑满8字节的倍数,不一定存在\n对象访问方式 句柄访问\n 使用句柄访问。java堆中将会划分出一块内存来作为句柄池,reference中存储的是对象的句柄地址,而句柄中包含了对象实例数据和类型数据各自的具体地址信息。\n直接指针访问\n\t使用直接指针访问。reference中存储的就是对象的地址。\nhotspot是用直接指针访问方式进行对象访问的。\n4. 内存分配机制 分配策略 对象优先分配到eden区\n大对象直接分配到老年代\n长期存活对象分配到老年代\n空间分配担保\n存入对象时发现年轻代空间不足,将判断老年代最大可用的连续空间是否大于当前年起代所有对象\n满足,minor gc是安全的,可以进行minor gc 不满足,虚拟机查看handlepromotionfailure参数 true会继续检测[老年代最大可用的连续空间]是否大于[历次晋升到老年代对象的平均大小]。若大于,将尝试进行一次minor gc,若失败,则重新进行一次full gc false则不允许冒险,要进行full gc 栈上分配和逃逸分析 在jdk7(包括)之后完全支持栈上分配和逃逸分析。\n逃逸分析\n\t如果某个方法之内创建的实例只在方法内被使用,方法结束之后没有任何对象引用它【即可被gc回收】,这样的对象叫做未发生逃逸对象。如果某个方法之内创建的实例在方法结束之后有对象引用它【即不可被gc回收】,这样的对象叫做逃逸对象。\n栈上分配\n\t如果一个对象未发生逃逸则这个对象的生命周期只存在一个方法体内,这样的对象可以直接在栈上分配提高效率,也方便回收【方法结束,栈销毁,未发生逃逸也就随着销毁】\n5. gc垃圾处理回收机制 鉴定垃圾对象 引用计数法\n\t在对象中添加一个引用计数器,当有地方释放这个引用时,对象上存储的引用计数减一,但是当出现互相引用时【对象实例3和对象实例5】引用计数依旧不为0,无法对其进行垃圾回收\n可达性分析\n\t该算法的核心算法是从gc roots对象作为起始点,如果对象不可达到gc root则认为此对象是要回收的对象。可作为gc roots的对象\n虚拟机栈的局部变量所引用的对象 本地方法栈的jni所引用的对象 方法区的静态变量和常量所引用的对象 回收策略 标记-清除算法\n\t算法分为标记和清除两个阶段:先标记出所有需要回收的对象,完成后统一回收掉所有被标记的对象。\n\t缺陷:①标记和清除过程的效率不高;②极易造成空间碎片问题\n复制收集算法\n\t复制收集算法将可用内存按容量划分为大小相等的两块,survivor区每次只使用其中的一块。当这一块的内存用完了,就将eden和survivor还存活着的对象复制到另外一块survivor上面,然后再把已使用过的内存空间一次清理掉。 这样内存分配时也就不用考虑内存碎片等复杂情况,实现简单运行高效。长期存活的对象移入oldgen区这里面的对象很少执行垃圾回收。\n标记-整理算法\n\t当预估能回收的对象并不多时(例如老年代)采用复制收集算法就要执行较多的复制操作,效率将会变低且还浪费了大量空间,所以此时进行复制收集算法不明智。采用标记-整理算法较为合适,标记过程仍然与“标记-清除”算法一样,但后续步骤不是直接对可回收对象进行清理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存。且下次在此空间继续分配内存可以使用指针碰撞法提高速度。\n分代收集算法\n\t把java堆分为新生代和老年代,根据各个年代的特点采用最适当的收集算法。新生代每次垃圾收集时都有大量对象需要回收那就选用复制算法。而老年代中因为对象存活率高就使用标记-清理或标记-整理算法进行回收。\ngc分类 minor gc:清理年轻代,不会影响到永久代\nmajor gc :清理老年代,major gc大部分由minor gc触发\nfull gc :清理整个堆空间—包括年轻代、老年代和永久代\n垃圾回收器 针对新生代的垃圾回收器 serial收集器【复制收集算法】\njdk1.3之前回收新生代内存的唯一选择 单线程的垃圾收集器,单cpu环境下效果较好 parnew【复制收集算法】\nserial收集器的多线程版本 parnew收集器是许多运行多cpu模式下的虚拟机中首选的新生代收集器 它是除了serial收集器外,唯一一个能与cms收集器配合工作的 parallel scavenge【复制收集算法】\n达到一个可控制的吞吐量有gc自适应调节策略 针对老年代的垃圾回收器 serial old 收集器【标记-整理算法】\n单线程垃圾收集器 parallel old 收集器【标记-整理算法】\nparallel scavenge的老年版本 cms 收集器【标记-清除算法】\n一种以获取最短回收停顿时间为目标的收集器 [1]初始标记:标记gc roots能直接到的对象。速度很快但是仍存在stop the world问题。\n[2]并发标记:进行gc roots tracing 的过程,找出存活对象且用户线程可并发执行。\n[3]重新标记:为了修正并发标记期间因用户程序继续运行发生改变的对象的记录。仍然存在stop the world。\n[4]并发清除:对标记的对象进行清除回收。\n特殊收集器 g1收集器\n\tg1垃圾收集器并没有将内存按照连续内存地址分为新生代、老年代。而是分成了一个个的区域【region】,采用了分代与分区算法。这些区域大小不固定,根据回收的情况进行评估,到达阀值视为老年代。在进行一次垃圾回收之后,会进行日志收集确定分代划分和是否进行混合清理(新生代和老年代一起清理)。\n并行性:g1回收期间可以多线程同时工作 并发性:g1拥有与应用程序交替执行的能力,部分工作可与应用程序同时执行,在整个gc期间不会完全阻塞应用程序 分代gc:依旧分为新生代和老年代,新生代依然有eden,from和to 空间整理:g1在垃圾回收过程中,不会像cms那样在若干次gc后需要进行碎片整理,g1采用了有效复制对象方式 可预见性:由于分区的原因,g1可以只选取部分区域进行回收,缩小了回收的范围,提高性能 g1的内存结构如下所示:\njdk11之后g1触发full gc时可并行处理,以前只能串行处理\n各代hotspot(server模式下)默认垃圾收集器 jdk1.7 默认垃圾收集器parallel scavenge(新生代)+parallel old(老年代) jdk1.8 默认垃圾收集器parallel scavenge(新生代)+parallel old(老年代) jdk1.9 默认垃圾收集器g1 附录 jit编译(just-in-time compilation) \t在部分商用虚拟机中(如hotspot),java程序最初是通过解释器(interpreter)进行解释执行的,当虚拟机发现某个方法或代码块的运行特别频繁时,就会把这些代码认定为“热点代码”。为了提高热点代码的执行效率,在运行时,虚拟机将会把这些代码编译成与本地平台相关的机器码,并进行各种层次的优化,完成这个任务的编译器称为即时编译器(just in time compile)。\n\t即时编译器并不是虚拟机必须的部分,java虚拟机规范并没有规定java虚拟机内必须要有即时编译器存在,更没有限定或指导即时编译器应该如何去实现。但是,即时编译器编译性能的好坏、代码优化程度的高低却是衡量一款商用虚拟机优秀与否的最关键的指标之一,它也是虚拟机中最核心且最能体现虚拟机技术水平的部分。\n\tjit编译狭义来说是当某段代码即将第一次被执行时进行编译,因而叫“即时编译”。jit编译是动态编译的一种特例。jit编译一词后来被泛化,时常与动态编译等价。\n符号引用\u0026amp;直接引用 符号引用(symbolic references)\n\t符号引用以一组符号来描述所引用的目标,符号可以是任何形式的字面量,只要使用时能够无歧义的定位到目标即可。例如,在class文件中它以constant_class_info、constant_fieldref_info、constant_methodref_info等类型的常量出现。符号引用与虚拟机的内存布局无关,引用的目标并不一定加载到内存中。\n直接引用(direct references)\n(1)直接指向目标的指针【比如指向class对象、类变量、类方法的直接引用可能是指向方法区的指针)\n(2)相对偏移量【比如指向实例变量、实例方法的直接引用都是偏移量】\n(3)一个能间接定位到目标的句柄\n管程 管程可以看做一个软件模块,它是将共享的变量和对于这些共享变量的操作封装起来,形成一个具有一定接口的功能模块,进程可以调用管程来实现进程级别的并发控制。\r进程只能互斥得使用管程,即当一个进程使用管程时,另一个进程必须等待。当一个进程使用完管程后,它必须释放管程并唤醒等待管程的某一个进程。\r在管程入口处的等待队列称为入口等待队列,由于进程会执行唤醒操作,因此可能有多个等待使用管程的队列,这样的队列称为紧急队列,它的优先级高于等待队列。 ","date":"2024-07-02","permalink":"https://hobocat.github.io/post/java/jvm/","summary":"1. JVMJDK\u0026amp;JRE\u0026amp;JVM之间的关系 JDK包含JRE和JVM,JRE包含JVM javac用于编译java代码到字节码文件 使用java命令启动","title":"jvm"},]

[{"content":"一、jdk\u0026amp;jre\u0026amp;jvm之间的关系 jdk包含jre和jvm,jre包含jvm javac用于编译java代码到字节码文件 使用java命令启动jvm,字节码最终运行在jvm上 【少】javafx是一种富客户端技术,用于替换flash和swing程序 【少】java web start第一次运行需要借助浏览器,之后生成快捷方式当web站点更新是程序也更新,效果类似swing 二、jvm虚拟机结构和厂商 sun classic vm\n第一款商用的java虚拟机,伴随着jdk1.0发布,只能使用纯解释器方式来执行java代码,只能外挂jit编译器(just-in-time compilation)进行编译java代码,但是解释器和jit编译器不能同时执行。存在较大性能问题。\nexact vm\nexact vm全称为exact memory management【准确式内存管理】,编译器和解释器可以混合工作以及两级及时编译器。但是只能在solaris平台使用。jdk1.2时发布。\nhotspotvm\n从jdk1.3开始运用至今的hotspot虚拟机(oracle jdk和open jdk)。加入热点代码探测技术。\nkvm\n面对移动设备和嵌入式设备的kilobyte虚拟机,运行速度较慢、简单、轻量、高度可移植。\njrockit\nbea公司(2008年被oracle收购)开发的jrockit虚拟机,被称为当时世界上最快的java虚拟机,专注于服务端应用。jdk7时部分功能被整合到hotspot。不包含解释器实现,只有即时编译器。\nj9\nibm开发类似hotspotvm虚拟机桌面、服务器、嵌入式端都支持。ibm内部使用。\ndalvik\n安卓操作系统所使用的虚拟机,并非是一个java虚拟机,未遵循java规范,基于寄存器架构【其它pc虚拟机基于栈架构】,不能执行.class文件。可以通过.class文件转化为.dex文件运行在dalvik上,开发的语法也为java,也可使用java api。\nmicorsoftvm\n只能在windows平台下运行,最终因为法律问题被sun公司禁止使用。\ntaobaovm\n根据hotspotvm深度定制,在淘宝内部使用,对硬件依赖性高。\nazul vm和 liquid vm\nazul vm和bea liquid vm是一类运行在特定硬件平台的专有虚拟机,是\u0026quot;高性能\u0026quot;虚拟机。\nazul vm是azul systems公司在hotspot基础上进行大量改进,运行于azul systems公司的专有硬件vega系统上的java虚拟机。每个azul vm实例都可以管理至少数十个cpu和数百gb内存的硬件资源,并提供在巨大内存范围内实现可控的gc时间的垃圾收集器、为专有硬件优化的线程调度等优秀特性。\nliquid vm即是现在的jrockit ve(virtual edition),由bea公司开发,可以直接运行在自家hypervisor系统上的jrockit vm的虚拟化版本,liquid vm不需要操作系统的支持,或者说它自己本身实现了一个专用操作系统的必要功能,如文件系统、网络支持等。由虚拟机越过通用操作系统直接控制硬件可以获得更好的性能,如在线程调度时,不需要再进行内核态/用户态的切换等,这样可以最大限度地发挥硬件的能力,提升程序的执行性能。\n三、jvm内存管理 程序计数器\n 程序计数器是一块比较小的内存空间,可以看作当前线程字节码所执行的行号指示器。属于线程独占区。如果线程执行的是java方法,则计数器的值是正在执行的字节码指令的地址。如果线程执行的是native方法,则计数器的值为undefined。\n虚拟机栈\n虚拟机栈描述的是java方法执行的动态内存模型\n栈帧:每个方法执行都会创建一个栈帧,栈帧伴随着方法的创建到执行完成,用于存储局部变量表、操作数栈、动态链接、方法出口等 局部变量表:用于保存方法的参数及局部变量,局部变量表内存空间大小在编译时期固定,在运行过程中不会改变局部变量表的大小 操作数栈:主要保存计算过程的中间结果,同时作为计算过程中变量临时的存储空间 本地方法栈\n\t本地方法栈为虚拟机执行native服务,结构和虚拟机栈完全相同。hotspotvm将虚拟机栈和本地方法栈放在一起管理不做区分。\njava堆\n\t存放对象的实例、垃圾收集器管理的主要区域。\n方法区\n\t属于线程共享区,存储了虚拟机加载的类信息【版本、字段、方法、接口】、运行时常量池【字面量和符号引用】、静态变量、即时编译器编译后的代码等数据。在hotspot中方法区是使用永久代实现的,所以永久代等于方法区。这里很少进行垃圾回收。\n从java8开始hotspots使用元空间取代了永久代,永久代物理是是堆的一部分而元空间属于本地内存。元空间存储类的元信息,静态变量和常量池等并入堆中。相当于永久代的数据被分到了堆和元空间中。\n直接内存【并非jvm规范定义的区域,不属于虚拟机运行时内存的一部分】\n\tjdk1.4为了弥补io缺陷引入nio,运行直接在堆外分配内存,不受jvm制约,由操作系统分配。\n四、java的对象 对象创建过程 对象内存分配方式 指针碰撞\n\t假设java堆中内存是绝对规整的,所有用过的内存都放在一边,空闲的内存放在另一边,中间放着一个指针作为分界点的指示器,那所分配内存就仅仅是把那个指针向空闲空间那边挪动一段与对象大小相等的距离,这种分配方式称为指针碰撞\n空闲列表\n\t如果java堆中的内存并不是规整的,已使用的内存和空闲的内存相互交错,那就没有办法简单地进行指针碰撞了,虚拟机就必须维护一个列表,记录上哪些内存块是可用的,在分配的时候从列表中找到一块足够大的空间划分给对象实例,并更新列表上的记录,这种分配方式称为空闲列表\n具体是使用空闲列表还是指针碰撞需要根据内存状况决定\n多线程内存分配管理 \t不管使用哪种对象内存分配方式,在多线程环境时,如果一个线程正在给a对象分配内存,指针还没有来的及修改,其它为b对象分配内存的线程,而且还是引用这之前的指针指向,这样会带来分配问题。于是有两种处理方式。\n分配时加锁\n\t堆是jvm中所有线程共享的,因此在其上进行对象内存的分配均需要进行加锁,这也导致了new对象的开销是比较大的。\ntlab【线程本地分配缓存区】\n\t为了提升对象内存分配的效率,对于所创建的线程都会分配一块独立的空间tlab(thread local allocation buffer),其大小由jvm根据运行的情况计算而得,在tlab上分配对象时不需要加锁,因此jvm在给线程的对象分配内存时会尽量的在tlab上分配,在这种情况下jvm中分配对象内存的性能和c基本是一样高效的,但如果对象过大的话则仍然是直接使用堆空间分配。\n\tjvm在内存新生代eden space中开辟了一小块线程私有的区域称作tlab。默认设定为占用eden space的1%。\n对象的结构 对象头\n_mark:用于存储对象自身的运行时数据,如哈希码(hashcode)、gc分代年龄、锁状态标志、线程持有的锁、偏向线程id、偏向时间戳等,称之为“markword” _klass:指向类元数据的指针 _length:数组长度(只有数组对象有) 实例数据\n\t存储在程序代码中所定义的各种类型的字段内容\n对齐填充\n\t帮助对象凑满8字节的倍数,不一定存在\n对象访问方式 句柄访问\n 使用句柄访问。java堆中将会划分出一块内存来作为句柄池,reference中存储的是对象的句柄地址,而句柄中包含了对象实例数据和类型数据各自的具体地址信息。\n直接指针访问\n\t使用直接指针访问。reference中存储的就是对象的地址。\nhotspot是用直接指针访问方式进行对象访问的。\n五、垃圾回收 鉴定垃圾对象 引用计数法\n\t在对象中添加一个引用计数器,当有地方释放这个引用时,对象上存储的引用计数减一,但是当出现互相引用时【对象实例3和对象实例5】引用计数依旧不为0,无法对其进行垃圾回收\n可达性分析\n\t该算法的核心算法是从gc roots对象作为起始点,如果对象不可达到gc root则认为此对象是要回收的对象。可作为gc roots的对象\n虚拟机栈的局部变量所引用的对象 本地方法栈的jni所引用的对象 方法区的静态变量和常量所引用的对象 回收策略 标记-清除算法\n\t算法分为标记和清除两个阶段:先标记出所有需要回收的对象,完成后统一回收掉所有被标记的对象。\n\t缺陷:①标记和清除过程的效率不高;②极易造成空间碎片问题\n复制收集算法\n\t复制收集算法将可用内存按容量划分为大小相等的两块,survivor区每次只使用其中的一块。当这一块的内存用完了,就将eden和survivor还存活着的对象复制到另外一块survivor上面,然后再把已使用过的内存空间一次清理掉。 这样内存分配时也就不用考虑内存碎片等复杂情况,实现简单运行高效。长期存活的对象移入oldgen区这里面的对象很少执行垃圾回收。\n标记-整理算法\n\t当预估能回收的对象并不多时(例如老年代)采用复制收集算法就要执行较多的复制操作,效率将会变低且还浪费了大量空间,所以此时进行复制收集算法不明智。采用标记-整理算法较为合适,标记过程仍然与“标记-清除”算法一样,但后续步骤不是直接对可回收对象进行清理,而是让所有存活的对象都向一端移动,然后直接清理掉端边界以外的内存。且下次在此空间继续分配内存可以使用指针碰撞法提高速度。\n分代收集算法\n\t把java堆分为新生代和老年代,根据各个年代的特点采用最适当的收集算法。新生代每次垃圾收集时都有大量对象需要回收那就选用复制算法。而老年代中因为对象存活率高就使用标记-清理或标记-整理算法进行回收。\ngc分类 minor gc:清理年轻代,不会影响到永久代\nmajor gc :清理老年代,major gc大部分由minor gc触发\nfull gc :清理整个堆空间—包括年轻代、老年代和永久代\n垃圾回收器 针对新生代的垃圾回收器 serial收集器【复制收集算法】\njdk1.3之前回收新生代内存的唯一选择 单线程的垃圾收集器,单cpu环境下效果较好 parnew【复制收集算法】\nserial收集器的多线程版本 parnew收集器是许多运行多cpu模式下的虚拟机中首选的新生代收集器 它是除了serial收集器外,唯一一个能与cms收集器配合工作的 parallel scavenge【复制收集算法】\n达到一个可控制的吞吐量有gc自适应调节策略 针对老年代的垃圾回收器 serial old 收集器【标记-整理算法】\n单线程垃圾收集器 parallel old 收集器【标记-整理算法】\nparallel scavenge的老年版本 cms 收集器【标记-清除算法】\n一种以获取最短回收停顿时间为目标的收集器 [1]初始标记:标记gc roots能直接到的对象。速度很快但是仍存在stop the world问题。\n[2]并发标记:进行gc roots tracing 的过程,找出存活对象且用户线程可并发执行。\n[3]重新标记:为了修正并发标记期间因用户程序继续运行发生改变的对象的记录。仍然存在stop the world。\n[4]并发清除:对标记的对象进行清除回收。\n特殊收集器 g1收集器\n\tg1垃圾收集器并没有将内存按照连续内存地址分为新生代、老年代。而是分成了一个个的区域【region】,采用了分代与分区算法。这些区域大小不固定,根据回收的情况进行评估,到达阀值视为老年代。在进行一次垃圾回收之后,会进行日志收集确定分代划分和是否进行混合清理(新生代和老年代一起清理)。\n并行性:g1回收期间可以多线程同时工作 并发性:g1拥有与应用程序交替执行的能力,部分工作可与应用程序同时执行,在整个gc期间不会完全阻塞应用程序 分代gc:依旧分为新生代和老年代,新生代依然有eden,from和to 空间整理:g1在垃圾回收过程中,不会像cms那样在若干次gc后需要进行碎片整理,g1采用了有效复制对象方式 可预见性:由于分区的原因,g1可以只选取部分区域进行回收,缩小了回收的范围,提高性能 g1的内存结构如下所示:\njdk11之后g1触发full gc时可并行处理,以前只能串行处理\n各代hotspot(server模式下)默认垃圾收集器 jdk1.7 默认垃圾收集器parallel scavenge(新生代)+parallel old(老年代) jdk1.8 默认垃圾收集器parallel scavenge(新生代)+parallel old(老年代) jdk1.9 默认垃圾收集器g1 六、内存分配 分配策略 对象优先分配到eden区\n大对象直接分配到老年代\n长期存活对象分配到老年代\n空间分配担保\n存入对象时发现年轻代空间不足,将判断老年代最大可用的连续空间是否大于当前年起代所有对象\n满足,minor gc是安全的,可以进行minor gc 不满足,虚拟机查看handlepromotionfailure参数 true会继续检测[老年代最大可用的连续空间]是否大于[历次晋升到老年代对象的平均大小]。若大于,将尝试进行一次minor gc,若失败,则重新进行一次full gc false则不允许冒险,要进行full gc 栈上分配和逃逸分析 在jdk7(包括)之后完全支持栈上分配和逃逸分析。\n逃逸分析\n\t如果某个方法之内创建的实例只在方法内被使用,方法结束之后没有任何对象引用它【即可被gc回收】,这样的对象叫做未发生逃逸对象。如果某个方法之内创建的实例在方法结束之后有对象引用它【即不可被gc回收】,这样的对象叫做逃逸对象。\n栈上分配\n\t如果一个对象未发生逃逸则这个对象的生命周期只存在一个方法体内,这样的对象可以直接在栈上分配提高效率,也方便回收【方法结束,栈销毁,未发生逃逸也就随着销毁】\n七、虚拟机工具 jps\n显示当前所有java进程pid相关信息\n参数 解释 -q 只显示pid,不显示class名称,jar文件名和传递给main方法的参数 -l 输出应用程序main class的完整package名或者应用程序的jar文件完整路径名 -m 输出传递给main方法的参数 -v 输出传递给jvm的参数 -v 隐藏输出传递给jvm的参数 jstat\n对java应用程序的资源和性能进行监控,包括了对类的装载、内存、jit编译和垃圾回收状况的监控。\n用法: jstat [option] [pid] [ []]\ninterval - 间隔的时间 count - 统计次数 参数 解释 -t 打印时打印时间戳 -class 显示classload的相关信息 -compiler 显示jit编译的相关信息 -gc 显示和gc相关的堆信息 -gccapacity 显示各个代的容量以及使用情况 -gcmetacapacity 显示metaspace的大小 -gcnew 显示年轻代信息 -gcnewcapacity 显示年轻代大小和使用情况 -gcold 显示老年代和永久代的信息 -gcoldcapacity 显示老年代的大小 -gcutil 显示垃圾收集信息 -gccause 显示垃圾收集信息并显示最后一次垃圾回收的诱因 -printcompilation 输出jit编译的方法信息 jinfo\n用于实时查看和调整虚拟机参数\n用法:jinfo [option] [pid]\n参数 解释 -flag [name] 输出对应名称的参数 -flag [[+/-]name] 开启或者关闭对应名称的参数 -flag [name=value] 设定对应名称的参数 -flags 输出全部的参数 -sysprops 输出系统属性 jmap\n用于生成java程序的dump文件, 以及查看堆内对象的统计信息、classloader的信息以及finalizer队列\n用法:jmap [option] [pid]\n参数 解释 -histo[:live] 显示堆中对象的统计信息 -clstats 打印类加载器信息 -finalizerinfo 显示在f-queue队列等待finalizer线程执行finalizer方法的对象 -dump:live,format=b,file=heap.bin 内存转储dump数据,过程中会暂停应用 jhat\n分析内存dump文件,会占用大量cpu和内存生成报告,默认最后会启动一个web服务端口7000,可访问查看相应指标信息,但是很少使用,不够直观灵活。\njstack\n查看生成线程状态信息\n用法:jstack [option] [pid]\n参数 解释 -l 长列表. 打印关于锁的附加信息 jconsole\n提供了内存、线程、线程死锁检测、类、vm概要等gui查看功能\nvisualvm\njdk8之后被移除默认的jdk安装包,需要单独下载,官方地址\n八、class文件 概述 \tclass文件是一组以8位字节为基础单位的二进制流,在当遇到8位字节以上数据项时,则按照高位在前的方式分割成若干个8位以上字节进行分别存储。各个数据项目按照严格顺序紧凑的排列在class文件之中,中间没有添加任何分隔符,整个class文件中存储的内容几乎全部都是程序运行的必要数据,没有空隙存在。\n\tclass文件中只有两种数据类型,分别是无符号数和表\nclass文件结构 顺序依次为:\n①魔数[4字节]\n②class文件版本[4字节]\n③常量池[长度不固定]\n④访问标志[2字节]\n⑤类索引[2字节]、父类索引[2字节]、接口索引集合[长度不固定]\n⑥字段表集合[长度不固定]\n⑦方法表集合[长度不固定]\n⑧属性表集合[长度不固定]\n长度 含义 数量 u4 magic 1 u2 minor_version 1 u2 major_version 1 u2 constant_pool_count 1 cp_info constant_pool constant_pool_count - 1 u2 access_flags 1 u2 this_class 1 u2 super_class 1 u2 interfaces_count 1 u2 interfaces interfaces_count u2 fields_count 1 field_info fields fields_count u2 methods_count 1 method_info methods methods_count u2 attribute_count 1 attribute_info attributes attributes_count 魔数\n用于区分是否是class文件,占四个字节,十六进制表示值为ca fe ba be\nclass文件版本\n占4字节为字节码版本,为小版本号minor_version[2字节]和主版本号major_version[2字节]的组合\n常量池\n长度不固定,先用两个字节描述长度,真实长度为描述长度减一【0位置代表无引用,它也占一位】\n常量池的组成:\n常量池计数器(constant_pool_count):占用前两个字节,记录着常量池的组成元素个数\n常量池项(cp_info):元素信息,一共constant_pool_count-1个数量\ncp_info结构如下:\n1 2 3 4 cp_info { ul tag; ul info[]; } 常量池数量是从1开始计数的并非从0开始,所有元素真实个数需要减一,将第0项常量空出来是为了满足执向常量池的索引数据在特定情况下表达“不引用任何一个常量池项”的含义\ncp_info的类型:\n常量类型 值 constant_class 7 constant_fieldref 9 constant_methodref 10 constant_interfacemethodref 11 constant_string 8 constant_integer 3 constant_float 4 constant_long 5 constant_double 6 constant_nameandtype 12 constant_utf8 1 constant_methodhandle 15 constant_methodtype 16 constant_invokedynamic 18 可使用javap -verbose [name].class查看常量池内容\n访问标志\naccess_flages占有两个字节,没有使用到的标志为要求一律为0\n标志名称 标志值 含义 acc_public 0x00 01 是否为public类型 acc_final 0x00 10 是否被声明为final,只有类可以设置 acc_super 0x00 20 是否允许使用invoke special字节码指令的新语义 acc_interface 0x02 00 标志这是一个接口 acc_abstract 0x04 00 是否为abstract类型,对于接口或者抽象类来说标志值为真 acc_synthetic 0x10 00 标志这个类并非由用户代码产生 acc_annotation 0x20 00 标志这是一个注解 acc_enum 0x40 00 标志这是一个枚举 可使用javap -verbose [name].class查看访问标志\n类索引、父类索引、接口索引集合\n类索引:占用两个字节,指向常量池中的引用\n父类索引:占用两个字节,指向常量池中的引用\n接口索引集合:统计个数interfaces_count占用两个字节,interfaces占用interfaces_count*2个字节,每个interfaces指向常量池中的引用\n字段表集合\n字段表【field_info】用于描述类中声明的变量,但是不包括在方法内部声明的局部变量\n字段表的结构:\n长度 名称 数量 u2 access_flags 1 u2 name_index 1 u2 descriptor_index 1 u2 attributes_count 1 attribute_info attributes attributes_count access_flags访问标志值:\n标志名称 标志值 含义 acc_public 0x00 01 字段是否为public acc_private 0x00 02 字段是否为private acc_protected 0x00 04 字段是否为protected acc_static 0x00 08 字段是否为static acc_final 0x00 10 字段是否为final acc_volatile 0x00 40 字段是否为volatile acc_transtent 0x00 80 字段是否为transient acc_synchetic 0x10 00 字段是否为由编译器自动产生 acc_enum 0x40 00 字段是否为enum 属性表集合\n在class文件,字段表,方法表都可以携带自己的属性表集合用于描述某些场景专有的信息\n属性名称 使用位置 含义 code 方法表 java代码编译成的字节码指令 constantvalue 字段表 final关键字定义的常量池 deprecated 类,方法表,字段表 被声明为deprecated的方法和字段 exceptions 方法表 方法抛出的异常 enclosingmethod 类文件 仅当一个类为局部类或者匿名类是才能拥有这个属性,这个属性用于标识这个类所在的外围方法 innerclass 类文件 内部类列表 linenumbertable code属性 java源码的行号与字节码指令的对应关系 localvariabletable code属性 方法的局部变量描述 stackmaptable code属性 供新的类型检查检验器检查和处理目标方法的局部变量和操作数有所需要的类是否匹配 signature 类,方法表,字段表 用于支持泛型情况下的方法签名 sourcefile 类文件 记录源文件名称 sourcedebugextension 类文件 用于存储额外的调试信息 synthetic 类,方法表,字段表 标志方法或字段为编译器自动生成的 localvariabletypetable 类 使用特征签名代替描述符,是为了引入泛型语法之后能描述泛型参数化类型而添加 runtimevisibleannotations 类,方法表,字段表 为动态注解提供支持 runtimeinvisibleannotations 表,方法表,字段表 用于指明哪些注解是运行时不可见的 runtimevisibleparameterannotation 方法表 作用与runtimevisibleannotations属性类似,只不过作用对象为方法 runtimeinvisibleparameterannotation 方法表 作用与runtimeinvisibleannotations属性类似,作用对象哪个为方法参数 annotationdefault 方法表 用于记录注解类元素的默认值 bootstrapmethods 类文件 用于保存invokeddynamic指令引用的引导方式限定符 字节码指令 \tjava虚拟机的指令由一个字节长度的、代表着某种特定操作含义的数字(称为操作码,opcode)以及跟随其后的零至多个代表此操作所需参数(称为操作数,operands)而构成。jvm字节码指令是基于栈架构的指令,安卓虚拟机是基于寄存器架构的指令。\n\t部分指令有类型区分:【i:integer】、【l:long】、【f:float】、【d:double】、【a:reference】\n加载与存储指令\n将一个局部变量加载到操作数栈:[i/l/f/d/a]load 将一个数值从操作数栈存储到局部变量表:[i/l/f/d/a]store 将一个常量加载到操作数栈: bipush 将取值为【-128~127】的常量入栈 sipush 将取值为【-32768~32767】的将常量入栈 ldc 将取值为【2147483648~2147483647】的将常量入栈 ldc_w 从由常量池中取出指的索引位的一个字长的值,然后将其压入栈 ldc2_w 从由常量池中取出指的索引位的两个字长的值,然后将其压入栈 aconst_null 将null对象引用压入栈 iconst_m1 将int类型且值为【-1】的压入栈 iconst_value 将int类型且值为【0、1、2、3、4、5】压入栈 lconst_value 将long类型且值为【0、1】压入栈 fconst_value 将float类型且值为【0、1、2】压入栈 dconst_value 将double类型且值为【0、1】压入栈 扩充局部变量表的访问索引指令:wide 运算指令\n加法指令:[i/l/f/d]add 减法指令:[i/l/f/d]sub 乘法指令:[i/l/f/d]mul 除法指令:[i/l/f/d]div 取余指令:[i/l/f/d]rem 取反指令:neg 位移指令:ishl(逻辑左移)、ishr(逻辑右移)、iushr(算术右移)【其余类型不常见】 按位或指令:ior【其余类型不常见】 按位与指令:iand【其余类型不常见】 按位异或指令:ixor【其余类型不常见】 局部变量自增指令:iinc【其余类型执行压栈常量1再进行相加操作】 类型转换指令\n\t类型转换指令可以将两种不同的数值类型进行相互转换,这些转换操作一般用于实现用户代码中的显示类型转换以及用来处理字节码指令集中的数据类型相关指令无法与数据指令一一对应的问题。\n分类:宽化类型处理和窄化类型处理\n宽化类型转换:i2l、i2f,i2d,l2f,l2d,f2d等 窄化类型转换:l2i、f2i,d2i,f2l,d2l,d2f等 对象创建与访问指令\n创建类的指令:new 创建数组的指令:newarray、anewarray 、multianewarray 访问类的字段指令:getfield、putfield、getstatic、putstatic 把数组元素加载到操作数栈:[b/c/s/i/l/f/d/a]aload 将操作数栈的元素存储到数组:[b/c/s/i/l/f/d/a]astore 取数组长度的指令:arraylength 检查实例类型指令:instanceof、checkcast 操作数栈管理指令\n一个元素和两个元素出栈指令:pop、pop2 复制栈顶一个或两个数值并将复制或双份复制值重新压入栈顶:dup、dup2、dup_x1、dup_x2 将栈顶的两个数值替换:swap 控制转移指令\n\t控制转移指令可以让jvm有条件或无条件地从指定的位置执行而不是继续下一条指令执行程序,可以认为控制转移指令就是在有条件或无条件地修改pc寄存器的值。\n条件分支:ifeq、iflt、ifle、ifne、ifgt、ifge、ifnull、ifnonnull、if_icmpeq、 if_icmpne、if_icmplt、if_icmpgt、if_icmple、if_icmpge、if_acmpeq和if_acmpne 复合条件分支:tableswitch、lookupswitch 无条件分支:goto、goto_w、jsr、jsr_w、ret 方法调用指令\n指令 解释 invokevirtual 指令用于调用对象的实例方法即非私有的实例方法,根据对象实际类型进行分派(虚方法分派) invokeinterface 指令用于调用对象的接口方法,会在运行时搜索一个实现了这个接口方法的对象,找出适合的方法进行调用 invokespecial 指令用于调用一些需要特殊处理的实例方法,包括初始化方法、私有方法和父类方法 invokestatic 指令用于调用类的static方法 invokedynamic jdk7之后支持,调用动态方法,在运行时动态解析出调用点限定符所引用的方法之后,调用该方法 方法返回指令\n\t返回指令是根据返回的数据类型进行区分的,有ireturn(返回值是boolean、byte、char、short和int)、lretrun、freturn、dreturn、areturn还有返回voide、实例初始化、类和接口的初始化使用的return\n异常处理指令\n\tathrow用于显示抛出异常时(明确throw new runtimeexception和exception均会),但是对于\u0026quot;i/0“这种未显示表明的抛出是不会使用athrow的。\n同步指令\n\tjava虚拟机可以支持方法级的同步和方法内部一段指令序列的同步,这两种同步结构都是使用管程(monitor)来支持的。\n\t方法级的同步是隐式的,无须通过字节码指令来控制,它实现在方法调用和返回操作之中。虚拟机可以从方法常量池的方法表结构中的acc_synchronized访问标志得知一个方法是否声明为同步方法。当方法调用时,调用指令将会检查方法的acc_synchronized访问标志是否被设置,如果设置了,执行线程就要求先成功持有管程,然后才能执行方法,最后当方法完成(无论是正常完成还是非正常完成)时释放管程。在方法执行期间,执行线程持有了管程,其他任何线程都无法再获取到同一个管程。如果一个同步方法执行期间抛出了异常,并且在方法内部无法处理此异常,那么这个同步方法所持有的管程将在异常抛到同步方法之外时自动释放。\n\t同步一段指令集通常是由java语言中的synchronized语句块来表示的,java虚拟机的指令集中有monitorenter和monitorexit两条指令来支持synchronized关键字的语义,正确实现synchronized关键字需要javac编译器与java虚拟机两者共同协作支持。\n九、类加载机制 \t一个java对象的创建过程往往包括两个阶段:类初始化阶段 和 类实例化阶段\n\t类的加载:代表jvm将java文件编译成class文件后,以二进制流的方式存放到运行时数据的方法区中,并在java的堆中创建一个java.lang.class对象,用来指向存放在方法堆中的数据结构。且虚拟机加载class文件是懒加载机制。\n类的加载 通过一个类的全限定名来获取定义此类的二进制字节流 文件方式【class文件、jar文件】 网络 程序生成【动态代理】 其它【jsp-会转换为servlet,数据库】 将这个字节流所代表的静态存储结构转化为方法区的运行时数据结构 在内存中生成一个代表这个类的class对象,作为这个类的各种数据的访问入口 类的验证 \t验证是连接的第一步,但是并非是必须的。这一阶段的目的是为了确保class文件的字流中包含的狺息符合当前虚拟机的要求,并且不会危害虚拟机自身的安全包含:\n文件格式验证 是否以魔数0xcaffebabe开头 主次版本号是否在虚拟机处理范围内 常量池中的常量是否有不被支持的常量类型 指向常量的各种索引值是否有指向不存在的常量 元数据验证 这个类是否有父类 这个类的父类是否继承不被允许的类(final修饰的类) 如果这个类不是抽象类,是否实现了接口要求实现的方法 类中的字段,方法是否与父类矛盾(例如出现不符合规则的方法重载) 字节码验证 保证任何时刻操作数栈的数据类型与指令代码序列能配合工作 保证跳转指令不会跳转到方法体以外的字节码指令 保证方法体中类型转换有效,如避免出现将父类对象赋值到子类数据类型上 符号引用验证 符号引用中通过字符串描述的全限定名是否能找到对应的类 在指定类中是否存在符合方法的字段描述符号 符号引用的类,字段,方法的访问性是否可以被当前类访问 类的准备 \t准备阶段正式为类的静态变量分配内存并设置变量的初始值。这些变量使用的内存都将在方法区中进行分配。设置的初始值并非我们指定的值而是这种变量的默认值,但是如果是被final修饰的常量则会被初始为我们指定的值\n类的解析 \t**解析阶段是将常量池中的符号引用替换为直接引用的过程。**在进行解析之前需要对符号引用进行解析,不同虚拟机实现可以根据需要判断到底是在类被加载器加载的时候对常量池的符号引用进行解析(也就是初始化之前),还是等到一个符号引用被使用之前进行解析(也就是在初始化之后)。如果一个符号引用进行多次解析请求,虚拟机中除了invokedynamic指令外,虚拟机可以对第一次解析的结果进行缓存(在运行时常量池中记录引用,并把常量标识为一解析状态),这样就避免了一个符号引用的多次解析。\n类或者接口解析\n要把一个类或者接口的符号引用解析为直接引用,需要以下三个步骤\n如果该符号引用不是一个数组类型,那么虚拟机将会把该符号代表的全限定名称传递给类加载器去加载这个类。这个过程由于涉及验证过程所以可能会触发其他相关类的加载\n如果该符号引用是一个数组类型,并且该数组的元素类型是对象。我们知道符号引用是存在方法区的常量池中的,该符号引用的描述符会类似”[java/lang/integer”的形式,将会按照上面的规则进行加载数组元素类型,如果描述符如前面假设的形式,需要加载的元素类型就是java.lang.integer ,接着由虚拟机将会生成一个代表此数组对象的直接引用\n如果上面的步骤都没有出现异常,那么该符号引用已经在虚拟机中产生了一个直接引用,但是在解析完成之前需要对符号引用进行验证,主要是确认当前调用这个符号引用的类是否具有访问权限,如果没有访问权限将抛出java.lang.illegalaccess异常\n字段解析\n对字段的解析需要首先对其所属的类进行解析,因为字段是属于类的,只有在正确解析得到其类的正确的直接引用才能继续对字段的解析。对字段的解析主要包括以下几个步骤:\n如果该字段符号引用就包含了简单名称和字段描述符都与目标相匹配的字段,则返回这个字段的直接引用,解析结束 否则,如果在该符号的类实现了接口,将会按照继承关系从下往上递归搜索各个接口和它的父接口,如果在接口中包含了简单名称和字段描述符都与目标相匹配的字段,那么久直接返回这个字段的直接引用,解析结束 否则,如果该符号所在的类不是object类的话,将会按照继承关系从下往上递归搜索其父类,如果在父类中包含了简单名称和字段描述符都相匹配的字段,那么直接返回这个字段的直接引用,解析结束 否则,解析失败,抛出java.lang.nosuchfielderror异常 如果最终返回了这个字段的直接引用,就进行权限验证,如果发现不具备对字段的访问权限,将抛出java.lang.illegalaccesserror异常\n类方法解析\n进行类方法的解析仍然需要先解析此类方法的类,在正确解析之后需要进行如下的步骤:\n类方法和接口方法的符号引用是分开的,所以如果在类方法表中发现class_index(类中方法的符号引用)的索引是一个接口,那么会抛出java.lang.incompatibleclasschangeerror的异常 如果class_index的索引确实是一个类,那么在该类中查找是否有简单名称和描述符都与目标字段相匹配的方法,如果有的话就返回这个方法的直接引用,查找结束 否则,在该类的父类中递归查找是否具有简单名称和描述符都与目标字段相匹配的字段,如果有,则直接返回这个字段的直接引用,查找结束 否则,在这个类的接口以及它的父接口中递归查找,如果找到的话就说明这个方法是一个抽象类,查找结束,返回java.lang.abstractmethoderror异常 否则,查找失败,抛出java.lang.nosuchmethoderror异常 如果最终返回了直接引用,还需要对该符号引用进行权限验证,如果没有访问权限,就抛出java.lang.illegalaccesserror异常\n接口方法解析\n同类方法解析一样,也需要先解析出该方法的类或者接口的符号引用,如果解析成功,就进行下面的解析工作:\n如果在接口方法表中发现class_index的索引是一个类而不是一个接口,那么也会抛出java.lang.incompatibleclasschangeerror的异常\n否则,在该接口方法的所属的接口中查找是否具有简单名称和描述符都与目标字段相匹配的方法,如果有的话就直接返回这个方法的直接引用。\n否则,在该接口以及其父接口中查找,直到object类,如果找到则直接返回这个方法的直接引用\n否则,查找失败\n类的初始化 初始化时机 对于初始化阶段,虚拟机规范严格规定了有且只有5种情况必须对类进行初始化(加载、验证、准备自然需在此之前开始):\n①遇到new、getstatic、putstatic、invokestatic这四条字节码指令时,如果类没有进行过初始化,则需要先触发其初始化。生成这四条指令的最常见的java代码场景是:\n使用new关键字实例化对象的时候\n读取或设置一个类的静态字段【被final修饰己在编译器把结果放入常量池的静态字段除外】\n调用一个类的静态方法的时候\n②使用java.lang.reflect包的方法对类进行反射调用的时,如果类没有进行过初始化则需要先触发其初始化\n③当初始化一个类的时候,如果发现其父类还没有进行过初始化,则需要先触发其父类的初始化\n④当虚拟机启动时,用户需要指定一个要执行的主类(包含main()方法的那个类),虚拟机会先初始化这个主类\n⑤当使用jdk7动态语言支持时,如果methodhandle实例最后的解析结果ref_getstatic、ref_putstatic、ref_invokestatic的方法句柄,并且这个方法句柄所对应的类没有进行初始化,则需要先出触发其初始化\n不执行初始化的例子\n调用类常量【public static final】 通过数组定义来引用类【base[] car = new base[5]】 通过子类引用父类的静态字段【base.parentvariable】时,子类不会被初始化 初始化过程 \t类初始化时类加载过程的最后一步,前面的类加载过程中,除了在加载阶段(类加载过程的一个阶段)应用程序可以通过自定义类加载器参与之外,其余动作完全由虚拟机主导和控制。到了初始化阶段,才真正开始执行类中定义的java程序代码。初始化阶段是执行类构造器\u0026lt;clinit\u0026gt;()方法的过程。\n\u0026lt;clinit\u0026gt;()方法执行过程中可能会影响程序运行行为:\n\u0026lt;clinit\u0026gt;()方法是由编译器自动收集类中的所有类变量的赋值动作和静态语句块中的语句合并产生的,编译器收集的顺序是由语句在源文件中出现的顺序所决定的,静态语句块中只能访问到定义在静态语句块之前的变量,定义在它之后的变量,在前面的静态语句块中可以赋值,但不能访问,属于非法向前引用。\n1 2 3 4 5 6 7 8 public class test { static { v = 3; system.out.println(v);\t//编译报错,只能赋值不能访问 } static int v = 1; } // 顺序执行最后v的值为\u0026#34;1\u0026#34; \u0026lt;clinit\u0026gt;()方法与类的构造函数(即类的实例构造器\u0026lt;init\u0026gt;()方法)不同,它不需要显式地调用父类构造器,虚拟机会保证在子类的\u0026lt;clinit\u0026gt;()方法执行之前,父类的\u0026lt;clinit\u0026gt;()方法已经执行完毕。因此在虚拟机中第一个被执行的\u0026lt;clinit\u0026gt;()方法一定是java.lang.object\n\u0026lt;clinit\u0026gt;()方法对于类(抽象类)或接口来说并不是必需的,如果一个类中没有静态语句块,也没有对变量的赋值操作,那么编译器可以不为这个类生成\u0026lt;clinit\u0026gt;()方法\n接口中不能使用静态语句块,但仍然有变量初始化的赋值操作,因此接口与类一样都会生成\u0026lt;clinit\u0026gt;()方法。但接口与类不同的是,执行接口的\u0026lt;clinit\u0026gt;()方法不需要先执行父接口的\u0026lt;clinit\u0026gt;()方法。只有当父接口中定义的变量使用时,父接口才会初始化。另外,接口的实现类在初始化时也一样不会执行接口的\u0026lt;clinit\u0026gt;()方法\n虚拟机会保证一个类的\u0026lt;clinit\u0026gt;()方法在多线程环境中被正确的加锁,同步,如果多个线程同时去初始化一个类,那么只会有一个线程去执行这个类的\u0026lt;clinit\u0026gt;()方法,其他线程都需要阻塞等待,直到活动线程执行\u0026lt;clinit\u0026gt;()方法完毕。在实际应用中这种阻塞引起的问问往往是很隐蔽\n十、类加载器 类加载器的种类 启动(bootstrap)类加载器\n\t启动类加载器主要加载的是jvm自身需要的类,这个类加载使用c++语言实现的,是虚拟机自身的一部分,它负责将 /lib路径下的核心类库或-xbootclasspath参数指定的路径下的jar包加载到内存中。它本身是虚拟机的一部分,所以它并不是一个java类,也就是无法在java代码中获取它的引用。即extension classloader的代码中的parent为null\n注意必由于虚拟机是按照文件名识别加载jar包的,如rt.jar,如果文件名不被虚拟机识别,即使把jar包丢到lib目录下也是没有作用的(出于安全考虑,bootstrap启动类加载器只加载包名为java、javax、sun等开头的类)\n扩展(extension)类加载器\n\t扩展类加载器是指sun公司实现的sun.misc.launcher$extclassloader类,由java语言实现的,是launcher的静态内部类,它负责加载/lib/ext目录下或者由系统变量-djava.ext.dir指定位路径中的类库,开发者可以直接使用标准扩展类加载器。\n系统(system)类加载器\n\t也称应用程序加载器是指 sun公司实现的sun.misc.launcher$appclassloader。它负责加载系统类路径java -classpath或-d java.class.path 指定路径下的类库,开发者可以直接使用系统类加载器,一般情况下该类加载是程序中默认的类加载器,通过classloader#getsystemclassloader()方法可以获取到该类加载器。\n自定义(custom)类加载器\n\t自定义类加载器由第三方实现,建议满足双亲委派模式。\n只有被同一个类加载器加载的类才会相等,相同的字节码被不同的类加载器加载的类不相同。\n双亲委派模式 \t双亲委派模式要求除了顶层的启动类加载器外,其余的类加载器都应当有自己的父类加载器【并非继承】采用组合关系来复用父类加载器的相关代码,类加载器间的关系如下:\n十一、虚拟机字节码执行引擎 运行时栈帧结构 栈:线程私有,生命周期跟线程相同,当创建一个线程时,同时会创建一个栈,栈的大小和深度都是固定的。\n栈帧:一个栈中可以有多个栈帧,栈帧是栈的元素,栈帧随着方法的调用而创建,随着方法的结束而消亡。栈帧存储了方法的局部变量表、操作数栈、动态连接和方法返回地址等信息。在活动线程中,只有位于栈顶的栈帧才是有效的,称为当前栈帧,与这个栈帧相关联的方法称为当前方法。\n在编译程序代码的时候,栈帧中需要多大的局部变量表,多深的操作数栈都已经完全确定了。因此一个栈帧需要分配多少内存,不会受到程序运行期变量数据的影响,而仅仅取决于具体的虚拟机实现。\n局部变量表\n\t局部变量表(local variable table) 是一组变量值存储空间,用于存放方法参数和方法内部定义的局部变量。在 java 程序编译为 class 文件时,就在方法的 code 属性的 max_locals 数据项中确定了该方法所需要分配的局部变量表的最大容量。 局部变量表的容量以变量槽(variable slot)为最小单位。\n操作数栈\n\t操作数栈和局部变量表在访问方式上存在着较大差异,操作数栈并非采用访问索引的方式来进行数据访问的,而是通过标准的入栈和出栈操作来完成一次数据访问。每一个操作数栈都会拥有一个明确的栈深度用于存储数值(max_stack)。\n动态连接\n\t在类加载解析时无法确定的符号引用(应该转为直接引用)在运行时进行动态确定转换为直接引用的过程叫做动态连接,包括动态分派、动态语言支持\n方法返回地址\n\t返回调用完成都需要返回到方法被调用的位置,程序才能继续执行,方法返回时可能需要在栈帧中保存一些信息,用来帮助恢复它的上层方法的执行状态。一般来说,方法正常退出时,调用者的pc计数器的值可以作为返回地址,栈帧中很可能会保存这个计数器值。而方法异常退出时,返回地址是要通过异常处理器表来确定的,栈帧中一般不会保存这部分信息。\n附加信息\n虚机规范中允许具的虚拟机实现增加一些规范里没有描述的到栈帧中。这部信息完全取决于虚拟机的实现。 方法调用 方法调用并不等同于方法的执行,方法调用阶段的唯一任务就是确定被调用方法的版本\n解析调用\n\t在类加载的类解析阶段就已经调用方法的版本即在编译期已经确定了调用的方法,这种调用方式称之为解析调用。\n\t在java中被final、private、static修饰的方法以及构造方法都是属于这种类型,在编译期间就可确定,对应编译出的字节码指令为invokestatic【调用静态方法】、invokespecial:调用非静态私有方法和final方法、构造方法(包括super)\n静态分派调用\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 public class staticdispatch { static class parent{ } static class child extends parent{ } public static void sayhello(parent p){ system.out.println(\u0026#34;hello,parent\u0026#34;); } public static void sayhello(child c) { system.out.println(\u0026#34;hello,child\u0026#34;); } public static void main(string[] args) { // 静态类型 实际类型 parent parent = new parent(); parent child = new child(); sayhello(parent); //hello,parent sayhello(child); //hello,parent } } \t我们把“parent”称为变量的静态类型,后面的“child”称为变量的实际类型,静态类型和实际类型在程序中都可以发生一些变化,区别是静态类型的变化仅仅在使用时发生,变量本身的静态类型不会被改变,并且最终的静态类型在编译阶段可知依旧是invokespecial调用。而实际类型变化的结果在运行期才确定,编译器在编译期并不知道一个对象的实际类型是什么。\n\t静态分派的典型应用是方法重载。编译器在重载时是通过参数的静态类型而不是实际类型作为判定的依据。并且静态类型在编译期解析阶段可知,因此,javac编译器会根据参数的静态类型决定使用哪个重载版本。\n动态分派调用\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 public class dynamicdispatch { static class parent{ public void sayhello(){ system.out.println(\u0026#34;hello,i am parent\u0026#34;); } } static class child extends parent{ @override public void sayhello(){ system.out.println(\u0026#34;hello,i am child\u0026#34;); } } public static void main(string[] args) { parent parent = new parent(); parent child = new child(); parent.sayhello(); // hello,i am parent child.sayhello(); // hello,i am child } } \t因为子类重写父类的方法,在运行阶段才可确定类型在方法调用时候jvm其实是使用了invokevirtual指令。java中采用oop-klass二分模型表示一个对象。klass保存着类的数据,在其中保存着方法表,方法表中保存着从父类继承下来,自己定义的所有方法,如果子类重写父类方法,那么在这个方法表中相同位置上的父类方法则会被覆盖。也就意味着从子类实例来说是无法找到父类该方法的。\n动态类型语言支持 静态类型语言:在非运行阶段,变量的类型是可以确定的,也就是变量是有类型的。\n动态类型语言:在非运行阶段,变量的类型是无法确定的,也就是变量是没类型的。但是值是有类型的,也就是运行期间可以确定变量的值类型。\njdk7新增对动态语言调用的支持invokedynamic,java里没有函数指针无法在运行时动态调用方法。\n1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 22 23 24 25 26 27 28 29 30 31 32 33 import static java.lang.invoke.methodhandles.lookup; import java.lang.invoke.methodhandle; import java.lang.invoke.methodtype; public class methodhandletest { static class classa { public void println(string s) { system.out.println(s); } } public static void main(string[] args) throws throwable { // 无论obj最终是哪个实现类,下面这句都能正确调用到println方法。 object obj = system.currenttimemillis() % 2 == 0 ? system.out : new classa(); /** * methodtype:代表“一个方法” * 第一个参数 - 方法的返回值 * 第一个参数 - 方法的具体参数 */ methodtype mt = methodtype.methodtype(void.class, string.class); /** * lookup()方法来自于methodhandles.lookup * 作用是在指定类中查找符合给定的方法名称、方法类型,并且符合调用权限的方法句柄。 * bindto()用于绑定本地变量表的第一个元素this */ methodhandle methodhandle = lookup().findvirtual(obj.getclass(), \u0026#34;println\u0026#34;, mt).bindto(obj); // 调用方法 methodhandle.invokeexact(\u0026#34;hello\u0026#34;); } } 附录 jit编译(just-in-time compilation) \t在部分商用虚拟机中(如hotspot),java程序最初是通过解释器(interpreter)进行解释执行的,当虚拟机发现某个方法或代码块的运行特别频繁时,就会把这些代码认定为“热点代码”。为了提高热点代码的执行效率,在运行时,虚拟机将会把这些代码编译成与本地平台相关的机器码,并进行各种层次的优化,完成这个任务的编译器称为即时编译器(just in time compile)。\n\t即时编译器并不是虚拟机必须的部分,java虚拟机规范并没有规定java虚拟机内必须要有即时编译器存在,更没有限定或指导即时编译器应该如何去实现。但是,即时编译器编译性能的好坏、代码优化程度的高低却是衡量一款商用虚拟机优秀与否的最关键的指标之一,它也是虚拟机中最核心且最能体现虚拟机技术水平的部分。\n\tjit编译狭义来说是当某段代码即将第一次被执行时进行编译,因而叫“即时编译”。jit编译是动态编译的一种特例。jit编译一词后来被泛化,时常与动态编译等价。\n符号引用\u0026amp;直接引用 符号引用(symbolic references)\n\t符号引用以一组符号来描述所引用的目标,符号可以是任何形式的字面量,只要使用时能够无歧义的定位到目标即可。例如,在class文件中它以constant_class_info、constant_fieldref_info、constant_methodref_info等类型的常量出现。符号引用与虚拟机的内存布局无关,引用的目标并不一定加载到内存中。\n直接引用(direct references)\n(1)直接指向目标的指针【比如指向class对象、类变量、类方法的直接引用可能是指向方法区的指针)\n(2)相对偏移量【比如指向实例变量、实例方法的直接引用都是偏移量】\n(3)一个能间接定位到目标的句柄\n管程 管程可以看做一个软件模块,它是将共享的变量和对于这些共享变量的操作封装起来,形成一个具有一定接口的功能模块,进程可以调用管程来实现进程级别的并发控制。 进程只能互斥得使用管程,即当一个进程使用管程时,另一个进程必须等待。当一个进程使用完管程后,它必须释放管程并唤醒等待管程的某一个进程。 在管程入口处的等待队列称为入口等待队列,由于进程会执行唤醒操作,因此可能有多个等待使用管程的队列,这样的队列称为紧急队列,它的优先级高于等待队列。 ","date":"2024-05-12","permalink":"https://hobocat.github.io/post/java/2024-05-12jvm/","summary":"一、JDK\u0026amp;JRE\u0026amp;JVM之间的关系 JDK包含JRE和JVM,JRE包含JVM javac用于编译java代码到字节码文件 使用java命令启动JV","title":"jvm详解"},]